Das Meta Llama 3.1 405B wurde offiziell angekündigt und hat sich bereits einen Namen gemacht, bevor seine KI-Fähigkeiten überhaupt auf den Markt gekommen sind. Dieses von Meta entwickelte Spitzenmodell bietet beispiellose Flexibilität, Kontrolle und Leistung, die mit den besten Closed-Source-KI-Modellen mithalten kann.

Gestern konnten einige Benutzer bereits einen ersten Eindruck von seinem Potenzial gewinnen und heute haben wir offizielle Benchmarktests, die seine beeindruckenden Fähigkeiten unterstreichen. Weitere Informationen zu den gestrigen Enthüllungen finden Sie hier.

Was ist Meta Llama 3.1 405B?

Heute erfahren wir hier alles Wissenswerte über Meta Llama 3.1 405B. Llama 3.1 405B ist eine Open-Source-KI, die sich bei einer Vielzahl von Aufgaben wie Allgemeinwissen, Navigation, Mathematik, Werkzeugnutzung und mehrsprachiger Übersetzung auszeichnet, während die Versionen mittlerer Stufe 70B und minimaler Stufe 8B ebenfalls in ihren jeweiligen Klassen hervorstechen. Mit einer Kontextlänge von 128 K und Unterstützung für acht Sprachen ist dieses Modell für die Handhabung komplexer und vielfältiger Anwendungen ausgelegt.

Llama 3.1 405B wurde mit mehr als 15 Billionen Token und mehr als 16.000 H100-GPUs trainiert und ist eines der leistungsstärksten und fähigsten KI-Modelle auf dem Markt. In diese KI ist viel Energie geflossen. Jetzt können wir mit den technischen Details beginnen.

Hauptmerkmale von Meta Llama 3.1 405B

Meta Lama 3.1 405B bietet mehrere erweiterte Funktionen:

- Erweiterte Kontextlänge: Unterstützt bis zu 128 K Kontextlänge, ideal für die Zusammenfassung langer Texte und komplexe Konversationen.

- Mehrsprachigkeit: Unterstützt mehrere Sprachen und ist daher vielseitig für globale Anwendungen geeignet.

- Erweiterter Werkzeuggebrauch: Kann zur erweiterten Funktionalität in verschiedene Tools integriert werden.

- Generierung synthetischer Daten: Erleichtert die Erstellung synthetischer Daten zur Verbesserung und zum Trainieren kleinerer Modelle.

- Modelldestillation: Ermöglicht die Destillation großer Modelle in kleinere, effizientere Versionen.

Meta hat mit mehr als 25 Unternehmen zusammengearbeitet, um Meta Lama 3.1 405B einfacher zu verwenden. Diese Ökosystemunterstützung macht es für Entwickler und Forscher einfacher, mit diesem leistungsstarken Modell zu arbeiten, selbst ohne Zugriff auf riesige Rechenressourcen.

So verwenden Sie Meta Llama 3.1 405B

Um Meta Llama 3.1 405B zu verwenden, folgen Sie diesen Schritten:

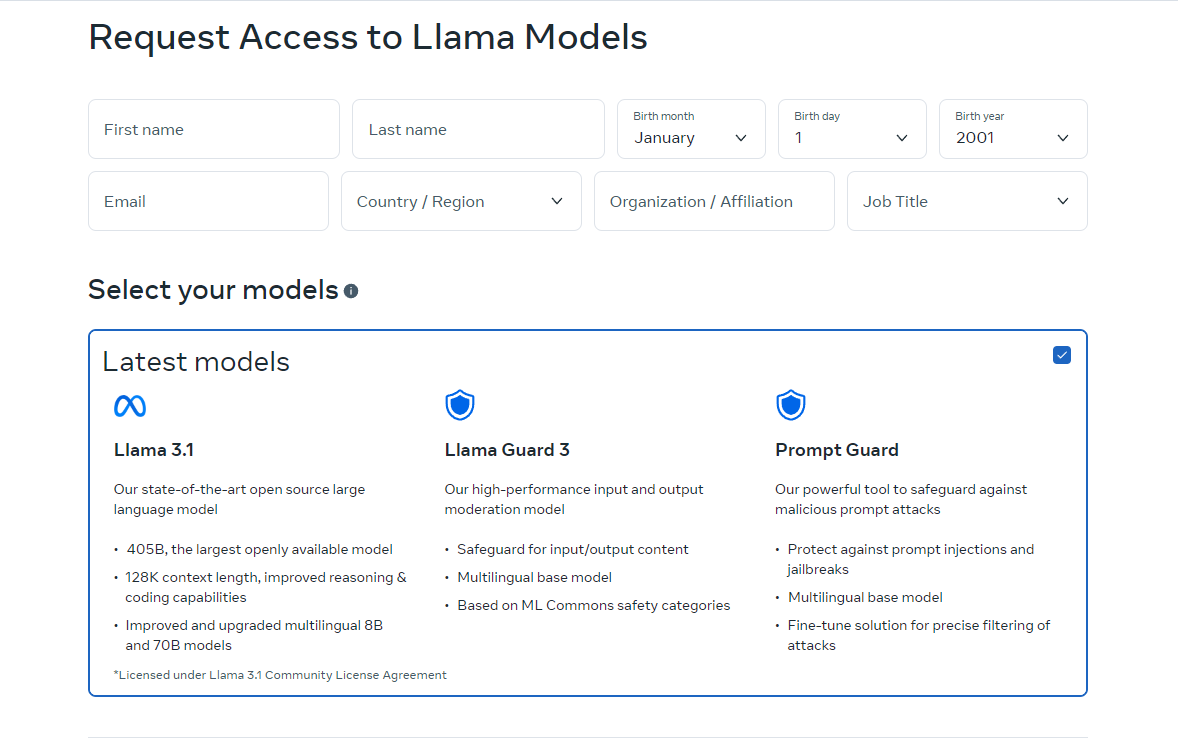

- Zugriff auf das Modell: Besuchen llama.meta.com oder Umarmendes Gesicht Zu herunterladen das Modell. Diese Plattformen stellen die erforderlichen Dateien und Dokumentationen für den Einstieg bereit.

- Einrichten Ihrer Umgebung: Stellen Sie sicher, dass Sie über eine geeignete Umgebung zum Ausführen des Modells verfügen. Dazu gehört die erforderliche Hardware, z. B. GPUs, und Softwareabhängigkeiten wie Python und PyTorch.

- Laden Sie das Modell: Verwenden Sie die bereitgestellten Codeausschnitte und Richtlinien, um das Modell in Ihre Anwendung zu laden. Meta bietet detaillierte Anweisungen, die Ihnen bei der Integration von Llama 3.1 405B in Ihre Projekte helfen.

- Inferenz ausführen: Beginnen Sie mit der Verwendung des Modells für Echtzeit- oder Batch-Inferenz. Sie können dem Modell Fragen stellen, Text generieren oder Übersetzungen mithilfe seiner leistungsstarken Funktionen durchführen.

- Feinabstimmung für spezifische Aufgaben: Bei Bedarf können Sie das Modell mithilfe überwachter Feinabstimmungstechniken für bestimmte Anwendungen optimieren. Meta bietet Ressourcen und Beispiele, die Sie durch diesen Prozess führen.

Die Online-Version von Llama ist derzeit nur in bestimmten Ländern verfügbar. Sie können sie jedoch auch lokal verwenden, indem Sie die Open-Source-Codes herunterladen. Anweisungen zum Herunterladen finden Sie auf den Websites, auf die wir Sie verweisen. Sie können Meta Llama 3.1 405B auch über Grog verwenden.

So verwenden Sie Meta Llama 3.1 405B auf Groq

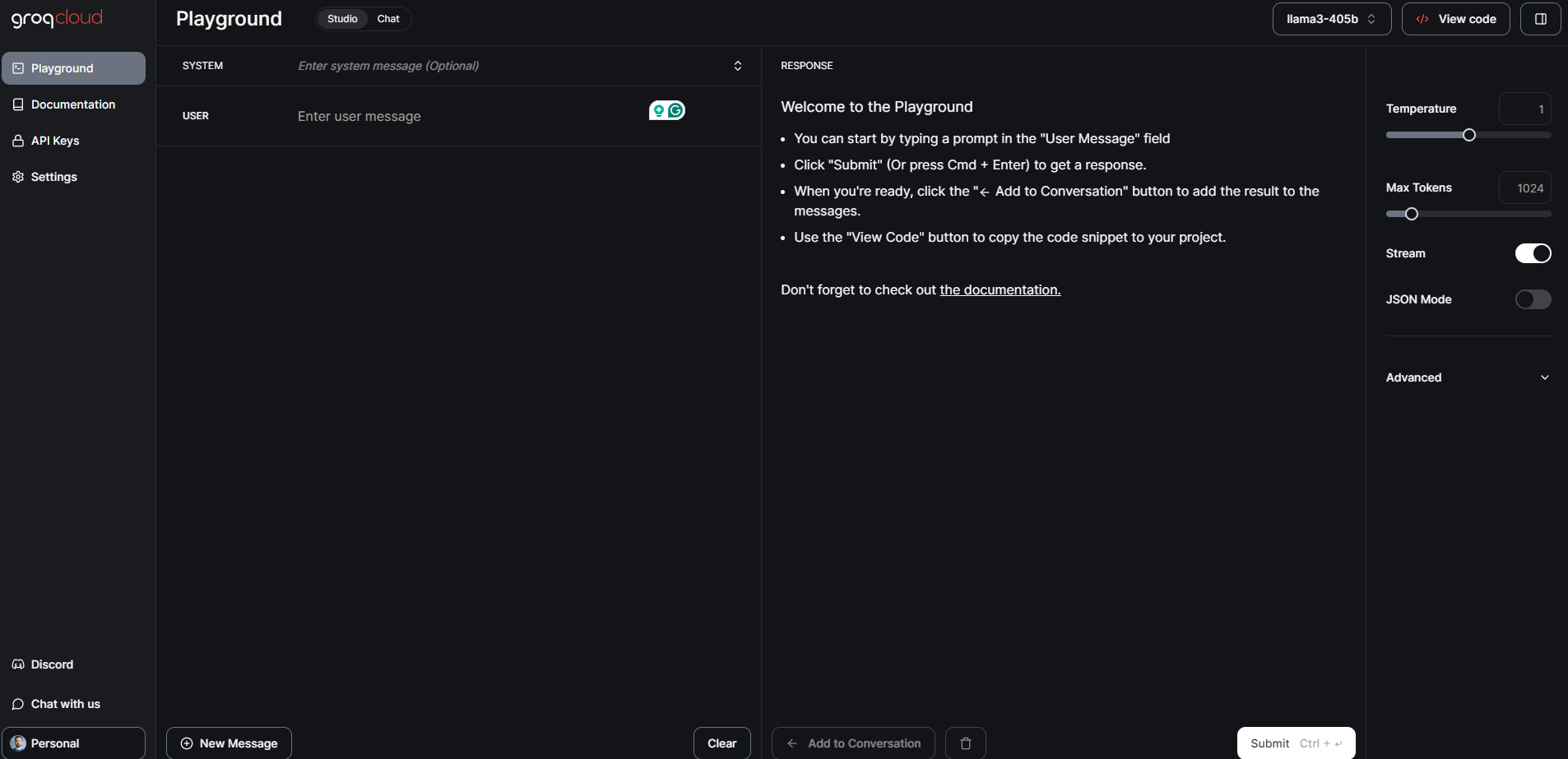

Meta Llama 3.1 405B, das bislang größte und leistungsfähigste Open-Foundation-Modell, ist jetzt auf Groq verfügbar. Diese Anleitung führt Sie durch die ersten Schritte mit Meta Llama 3.1 405B auf Groq.

Schritt 1: GroqCloud Dev Console

- Registrieren Einloggen: Besuche den GroqCloud-Entwicklerkonsole und melden Sie sich an oder melden Sie sich bei Ihrem Konto an.

- Meta Llama 3.1-Modelle finden: Navigieren Sie zum Abschnitt „Modelle“ und suchen Sie nach Meta Llama 3.1 405B. Dort finden Sie auch die verfügbaren Instruct-Modelle 70B und 8B.

- Einen API-Schlüssel erhalten: Erhalten Sie einen kostenlosen Groq API-Schlüssel von der Konsole. Mit diesem Schlüssel können Sie mit dem Modell interagieren.

sarkastisch

Für den allgemeinen öffentlichen Zugriff können Sie GroqChat verwenden:

- Besuchen Sie GroqChat: Gehe zu sarkastisch um direkt mit Meta Llama 3.1 405B zu interagieren.

- Entdecken Sie die Funktionen: Testen Sie die Funktionen des Modells in Echtzeit, z. B. das Generieren von Text, Übersetzungen oder Beantworten von Abfragen.

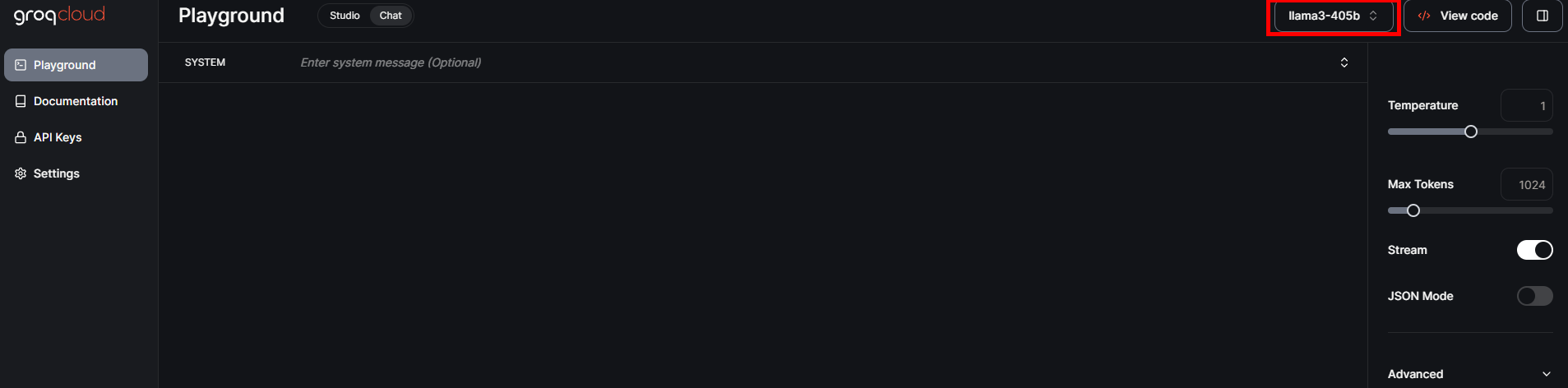

Schritt 2: Einrichten Ihrer Umgebung

Hardware- und Softwareanforderungen

- Hardware: Stellen Sie sicher, dass Sie über geeignete Hardware, vorzugsweise GPUs, verfügen, um die Anforderungen des Modells zu erfüllen.

- Software: Installieren Sie erforderliche Softwareabhängigkeiten wie Python und PyTorch. Detaillierte Einrichtungsanweisungen finden Sie in der GroqCloud Dev Console.

Umgebungskonfiguration

- API-Integration: Ersetzen Sie Ihren vorhandenen Industriestandard-API-Schlüssel durch den Groq-API-Schlüssel.

- Basis-URL festlegen: Konfigurieren Sie Ihre Anwendung so, dass sie die Basis-URL von Groq für API-Anfragen verwendet.

Schritt 3: Laden und Ausführen des Modells

Laden des Modells

- Code Ausschnitte: Verwenden Sie die bereitgestellten Codeausschnitte in der GroqCloud Dev Console, um Meta Llama 3.1 405B in Ihre Anwendung zu laden.

- Initialisierung: Initialisieren Sie das Modell mit dem API-Schlüssel und richten Sie alle erforderlichen Parameter für Ihren spezifischen Anwendungsfall ein.

Ausführen von Inferenz

- Echtzeit-Inferenz: Beginnen Sie mit der Ausführung von Echtzeit-Inferenzen, indem Sie Abfragen an das Modell senden und Antworten erhalten.

- Stapelverarbeitung: Bei größeren Aufgaben können Sie die Stapelverarbeitung verwenden, um mehrere Abfragen gleichzeitig zu bearbeiten.

Schritt 4: Feinabstimmung für spezifische Aufgaben

- Trainingsdaten: Bereiten Sie Ihren Datensatz für die spezifische Anwendung vor, für die Sie das Modell optimieren möchten.

- Feinabstimmungsprozess: Befolgen Sie die detaillierten Anweisungen von Meta und Groq, um das Modell mithilfe überwachter Techniken zu optimieren.

- Validierung: Validieren Sie das fein abgestimmte Modell, um sicherzustellen, dass es die gewünschten Leistungskriterien erfüllt.

Meta Llama 3.1 405B: Benchmarktests und Leistung

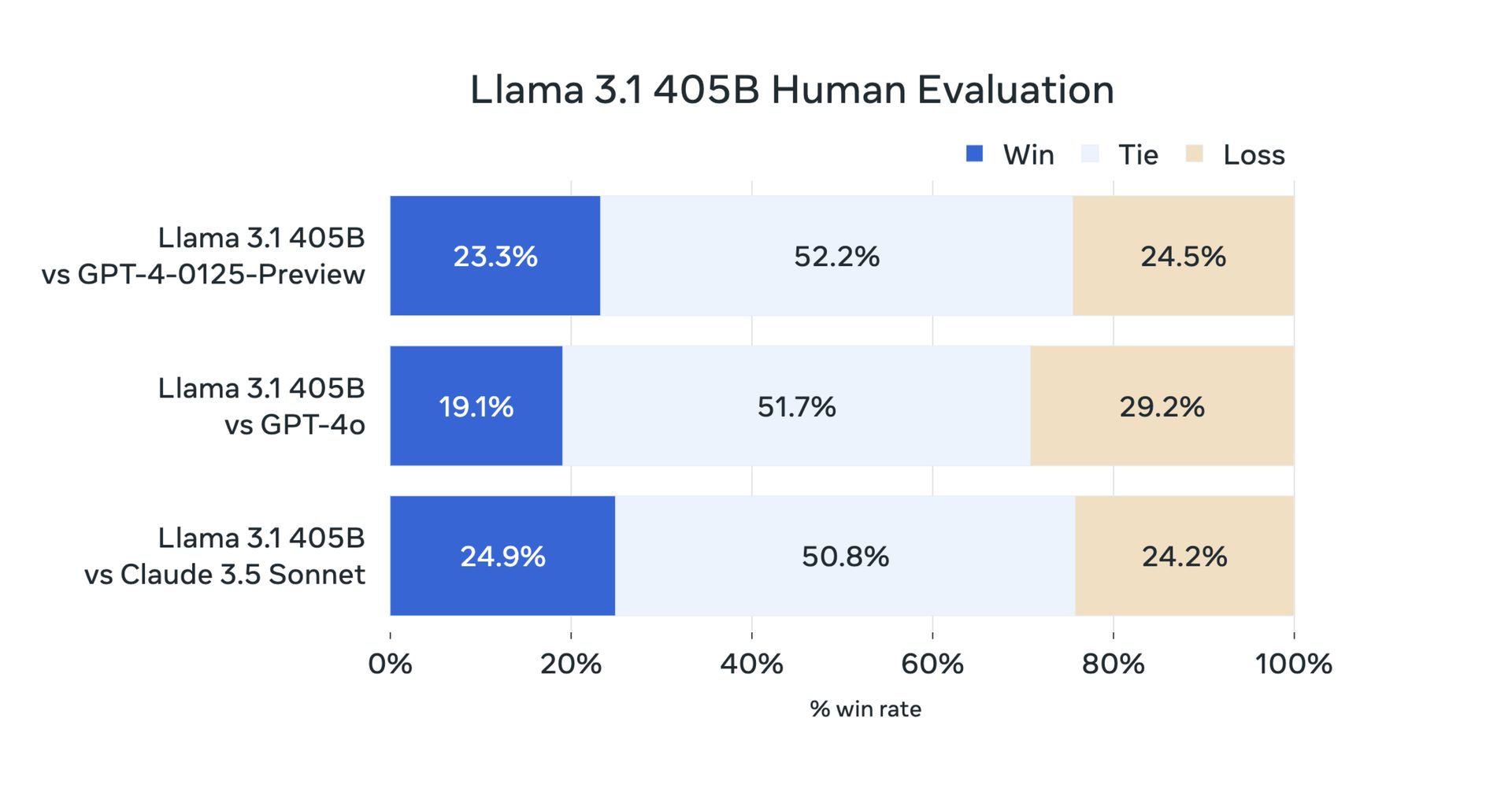

Aufgrund seines Open-Source-Charakters haben Benutzer gestern ihre Tests durchgeführt. Doch nun haben offizielle Benchmarktests bestätigt, dass Meta Llama 3.1 405B bei einer Vielzahl von Aufgaben außergewöhnlich gut abschneidet. Das Modell wurde anhand von mehr als 150 Benchmark-Datensätzen bewertet und mit führenden Modellen wie GPT-4 und Claude 3.5 Sonnet verglichen. Die Ergebnisse zeigen, dass Llama 3.1 405B mit diesen Topmodellen konkurrenzfähig ist und in realen Szenarien eine qualitativ hochwertige Leistung liefert.

Hier zunächst die Benchmarks für Llama 3.1 8B und Llama 3.1 70B:

| Kategorie | Benchmark | Lama 3.1 8B | Gemma 2 9B IT | Mistral 7B Anleitung | Lama 3.1 70B | Mixtral 8x22B Anleitung | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Allgemein | MMLU (0-Schuss, CoT) | 73,0 | 72,3 | 60,5 | 86,0 | 79,9 | 69,8 |

| Allgemein | MMLU PRO (5-Schuss, CoT) | 48,3 | – | 36,9 | 66,4 | 56,3 | 49.2 |

| Allgemein | IFEval | 80,4 | 73,6 | 57,6 | 87,5 | 72,7 | 69,9 |

| Code | HumanEval (0-Schuss) | 72,6 | 54,3 | 40,2 | 80,5 | 75,6 | 68,0 |

| Code | MBPP EvalPlus (Basis) (0-Schuss) | 72,8 | 71,7 | 49,5 | 86,0 | 78,6 | 82,0 |

| Mathematik | GSM8K (8-Schuss, CoT) | 84,5 | 76,7 | 53.2 | 95,1 | 88,2 | 81,6 |

| Mathematik | MATH (0-Schuss, CoT) | 51,9 | 44.3 | 13,0 | 68,0 | 54.1 | 43.1 |

| Argumentation | ARC-Herausforderung (0-Schuss) | 83,4 | 87,6 | 74,2 | 94,8 | 88,7 | 83,7 |

| Argumentation | GPQA (0-Schuss, CoT) | 32,8 | – | 28,8 | 46,7 | 33.3 | 30,8 |

| Werkzeuggebrauch | BFCL | 76.1 | – | 60,4 | 84,8 | – | 85,9 |

| Werkzeuggebrauch | Nexus | 38,5 | 30,0 | 24,7 | 56,7 | 48,5 | 37.2 |

| Langer Kontext | ZeroSCROLLS/Qualität | 81,0 | – | – | 90,5 | – | – |

| Langer Kontext | InfiniteBench/En.MC | 65.1 | – | – | 78,2 | – | – |

| Langer Kontext | NIH/Mehrnadel | 98,8 | – | – | 97,5 | – | – |

| Mehrsprachig | Mehrsprachiges MGSM (0-Shot) | 68,9 | 53.2 | 29,9 | 86,9 | 71.1 | 51,4 |

Und es gibt einen Meta Llama 3.1 405B-Benchmark:

| Kategorie | Benchmark | Lama 3.1 405B | Nemotron 4 340B Anleitung | GPT-4 (0125) | GPT-4 Omni | Claude 3.5 Sonett |

|---|---|---|---|---|---|---|

| Allgemein | MMLU (0-Schuss, CoT) | 88,6 | 78,7 (nicht CoT) | 85,4 | 88,7 | 88,3 |

| Allgemein | MMLU PRO (5-Schuss, CoT) | 73,3 | 62,7 | 64,8 | 74,0 | 77,0 |

| Allgemein | IFEval | 88,6 | 85,1 | 84,3 | 85,6 | 88,0 |

| Code | HumanEval (0-Schuss) | 89,0 | 73,2 | 86,6 | 90,2 | 92,0 |

| Code | MBPP EvalPlus (Basis) (0-Schuss) | 88,6 | 72,8 | 83,6 | 87,8 | 90,5 |

| Mathematik | GSM8K (8-Schuss, CoT) | 96,8 | 92,3 (0 Schuss) | 94,2 | 96,1 | 96,4 (0 Schuss) |

| Mathematik | MATH (0-Schuss, CoT) | 73,8 | 41.1 | 64,5 | 76,6 | 71.1 |

| Argumentation | ARC-Herausforderung (0-Schuss) | 96,9 | 94,6 | 96,4 | 96,7 | 96,7 |

| Argumentation | GPQA (0-Schuss, CoT) | 51.1 | – | 41.4 | 53,6 | 59,4 |

| Werkzeuggebrauch | BFCL | 88,5 | 86,5 | 88,3 | 80,5 | 90,2 |

| Werkzeuggebrauch | Nexus | 58,7 | – | 50,3 | 56.1 | 45,7 |

| Langer Kontext | ZeroSCROLLS/Qualität | 95,2 | – | – | 90,5 | 90,5 |

| Langer Kontext | InfiniteBench/En.MC | 83,4 | – | 72.1 | 82,5 | – |

| Langer Kontext | NIH/Mehrnadel | 98,1 | – | 100,0 | 100,0 | 90,8 |

| Mehrsprachig | Mehrsprachiges MGSM (0-Shot) | 91,6 | – | 85,9 | 90,5 | 91,6 |

Meta Llama 3.1 405B stellt einen Fortschritt in der Open-Source-KI dar, indem es Entwicklern und Forschern ein leistungsstarkes Tool für eine Vielzahl von Anwendungen bietet. Mit seinen erweiterten Funktionen, seinem robusten Ökosystem und seinem Engagement für verantwortungsvolle Entwicklung hoffen wir, dass Llama 3.1 405B den 70B- und 8B-KI-Communitys Innovationen bringen wird. Hier ist alles, was wir für Sie vorbereitet haben.

Bildnachweis: Meta-KI

Source: Alles, was Sie über Meta Llama 3.1 405B wissen müssen