Gemma 2 ist gerade auf der 2D-KI-Szene aufgetaucht und sorgt für ziemliches Aufsehen. Dieses winzige Modell beweist, dass gute Dinge in kleinen Paketen kommen, und löst in der Technikwelt eine echte Diskussion aus.

Googles neueste Erfindung, Gemma 2 2B, ist ein kompaktes Sprachmodell mit nur 2,6 Milliarden Parametern. Trotz seiner geringen Größe ist dieses KI-Kraftpaket seinen größeren Geschwistern ebenbürtig. Gemma 2 2B kann nicht nur viel versprechen, sondern ist auch leistungsfähiger als zehnmal so große Modelle.

Die brillante Leistung von Gemma 2 2B

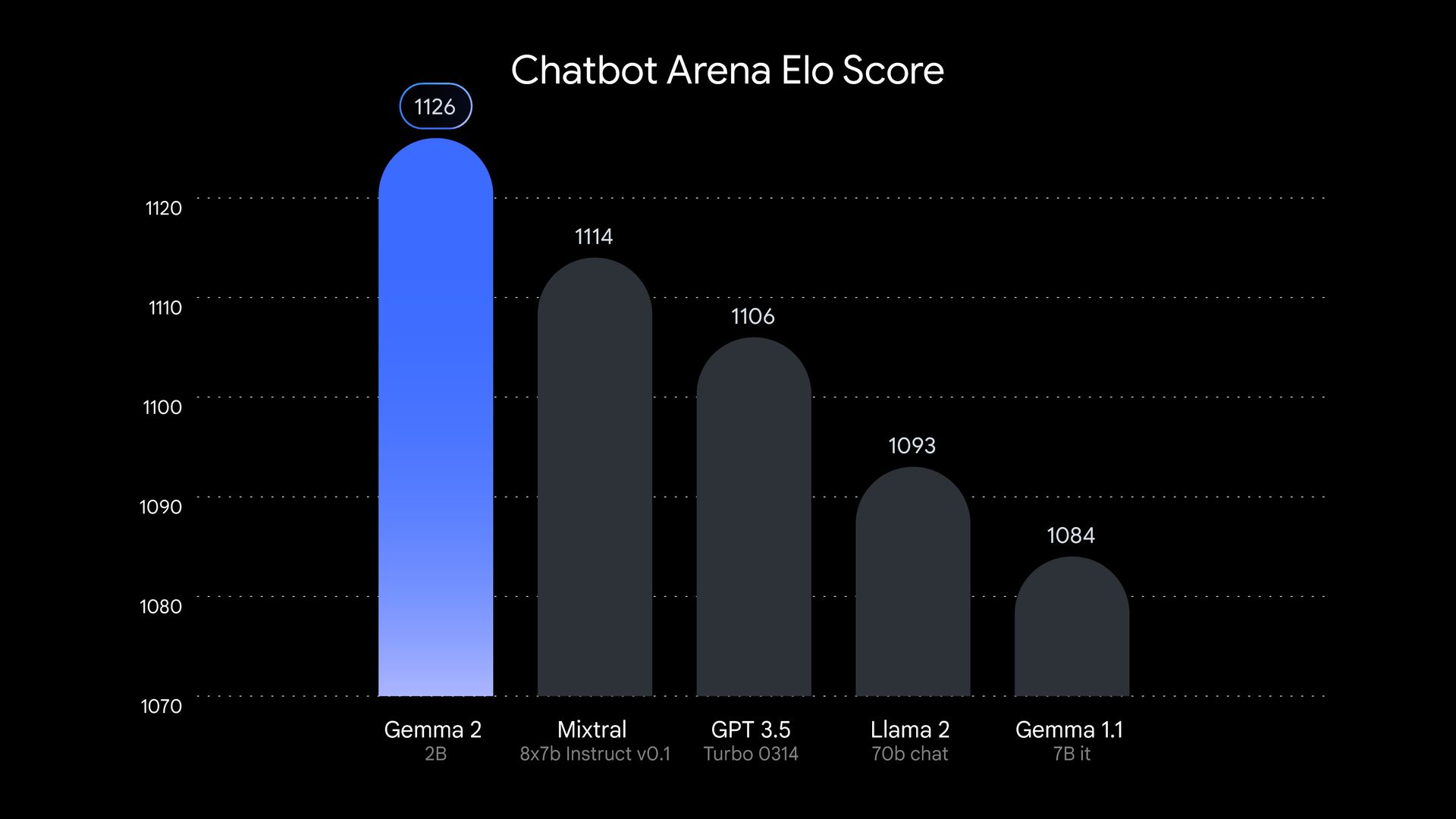

Lassen Sie uns klarstellen, dass Gemma 2 2B keine weitere große Kraft in der großen KI-Crowd ist. Dieses Modell wurde auf die Probe gestellt und hat sich als glänzend erwiesen. In Tests, die von LMSYSeine unabhängige KI-Forschungsgruppe, Gemma 2 2B erzielte eine beeindruckende 1130 Punkte im Bewertungsbereich. Das stimmt, dieses kleine Juwel hat einige große Namen wie GPT-3.5-Turbo-0613 und Mixtral-8x7B übertroffen.

Aber die Gemma 2 2B ist noch nicht alles. Sie zeigt, dass sie auch in anderen Bereichen intelligent ist. In der MMLU Benchmark, der die Fähigkeit eines Modells testet, verschiedene Themen zu verstehen und zu begründen, erreichte das Gemma 2 2B 56,1 Punkte. Beim Codieren erreichte es 36,6 Punkte im MBPP Test. Diese Zahlen stellen einen Quantensprung gegenüber seinem Vorgänger dar.

Wie kam es also Google erstellt dieses kleine Wunder? Gemma 2 2B wurde mithilfe der fortschrittlichen TPU v5e-Hardware von Google anhand eines riesigen Datensatzes von 2 Billionen Token trainiert. Durch diesen Trainingsprozess konnte das Modell viele Informationen in seinen kompakten Rahmen packen. Gemma 2 2B ist außerdem mehrsprachig, was seine potenziellen Anwendungsfälle weltweit erweitert. Dies macht es zu einem vielseitigen Werkzeug für Entwickler und Forscher, die an internationalen Projekten arbeiten.

Der Erfolg von Gemma 2 2B stellt die Vorstellung in Frage, dass in der KI größer immer besser ist. Seine beeindruckende Leistung zeigt, dass kleinere Modelle mit den richtigen Trainingstechniken, effizienten Architekturen und hochwertigen Daten weit über ihre Gewichtsklasse hinauswachsen können. Diese Entwicklung könnte den Schwerpunkt der KI-Forschung von der Erstellung größerer Modelle auf die Verbesserung kleinerer, effizienterer Modelle verlagern. Dies ist eine Veränderung, die weitreichende Auswirkungen auf das Feld haben und KI möglicherweise zugänglicher und umweltfreundlicher machen könnte.

Die Zukunft der KI polieren

Gemma 2 2D steht für einen wachsenden Trend in der KI hin zu effizienteren Modellen. Angesichts wachsender Bedenken hinsichtlich der Umweltauswirkungen und der Zugänglichkeit großer Sprachmodelle suchen Technologieunternehmen nach Möglichkeiten, kleinere Systeme zu erstellen, die auf alltäglicher Hardware ausgeführt werden können.

Der Erfolg von Gemma 2 2D unterstreicht auch die Bedeutung von Modellkomprimierungs- und Destillationstechniken. Durch die effektive Verdichtung von Wissen aus größeren Modellen in kleinere können Forscher leichter zugängliche KI-Tools erstellen, ohne die Leistung zu beeinträchtigen.

Dieser Ansatz reduziert nicht nur die zum Ausführen dieser Modelle erforderliche Rechenleistung, sondern berücksichtigt auch Bedenken hinsichtlich der Umweltauswirkungen des Trainings und des Betriebs großer KI-Systeme. Dies ist eine Win-Win-Situation, die die Zukunft der KI-Entwicklung prägen könnte.

Gemma 2 2B beweist, dass es bei KI nicht auf die Größe ankommt, sondern darauf, wie man sie einsetzt. Dieses kleine, aber leistungsstarke Modell stellt unsere Annahmen über KI in Frage und ebnet den Weg für eine neue Generation effizienter, leistungsstarker und zugänglicher KI-Systeme. Es ist klar, dass dieses kleine Juwel in der Welt der KI glänzen wird.

Bildnachweis: Google

Source: Auf die Größe kommt es nicht an: Gemma 2 2B beweist, dass KI klein denken kann