Mistral Large 2 ist da und bringt ein neues Niveau an Komplexität in Sprachmodelle. Mit seinen gewaltigen 123 Milliarden Parametern und einem beeindruckenden Kontextfenster von 128.000 Token kann dieses Modell lange Texte und komplexe Konversationen mit Leichtigkeit bewältigen. Es ist auf Präzision ausgelegt, reduziert Informationsfehler und ist hervorragend für Codierungs- und mehrsprachige Aufgaben geeignet.

Erfahren Sie, wie die erweiterten Funktionen von Mistral Large 2 die Grenzen der KI erweitern, von der Lösung mathematischer Probleme bis hin zur Unterstützung einer breiten Palette von Programmiersprachen.

Mistral Large 2: Ein umfassender Überblick

Mistral Large 2 stellt einen bedeutenden Fortschritt auf dem Gebiet der Sprachmodelle dar und kombiniert beträchtliche Skalierbarkeit mit Spitzentechnologie. Aus diesem Grund ist Folgendes zu sagen:

Modellmaßstab und Kontextfenster

Mistral Large 2 zeichnet sich durch seine 123 Milliarden Parameter aus. Parameter sind die Kernkomponenten eines Sprachmodells und ermöglichen es diesem, anhand von Mustern, die in seinen Trainingsdaten gefunden werden, zu lernen und Text zu generieren. Die große Anzahl an Parametern ermöglicht es Mistral Large 2, komplexere und differenziertere Texte zu verstehen und zu generieren.

Das Modell verfügt außerdem über ein umfangreiches Kontextfenster mit 128.000 Token. Dank dieses großen Kontextfensters kann Mistral Large 2 Text verarbeiten und generieren und dabei auch bei sehr langen Textpassagen die Kohärenz wahren. Dadurch eignet es sich optimal für die Verarbeitung langer Dokumente und ausführlicher Gespräche.

Eine große Herausforderung bei Sprachmodellen ist die Generierung plausibel klingender, aber falscher Informationen, sogenannter Halluzinationen. Mistral Large 2 wurde speziell darauf trainiert, dieses Problem zu reduzieren. Es ist so konzipiert, dass es erkennt, wenn es nicht über ausreichende Informationen verfügt, anstatt potenziell irreführende Inhalte zu generieren. Diese Verbesserung erhöht die Genauigkeit und Zuverlässigkeit des Modells.

Leistung bei Benchmarks

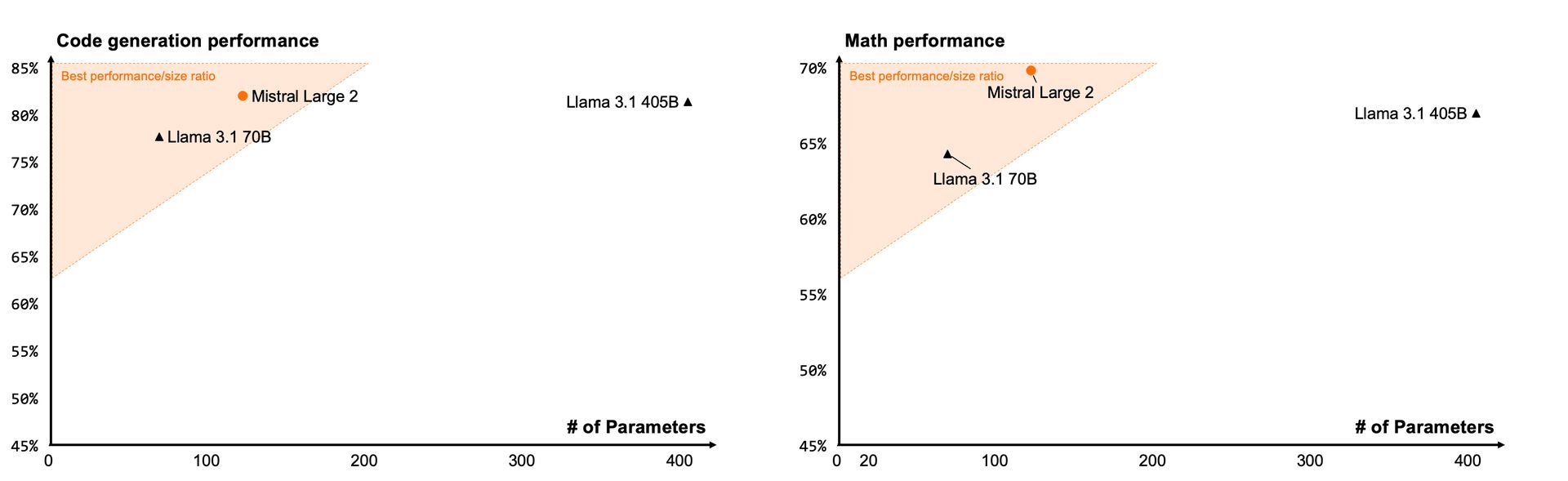

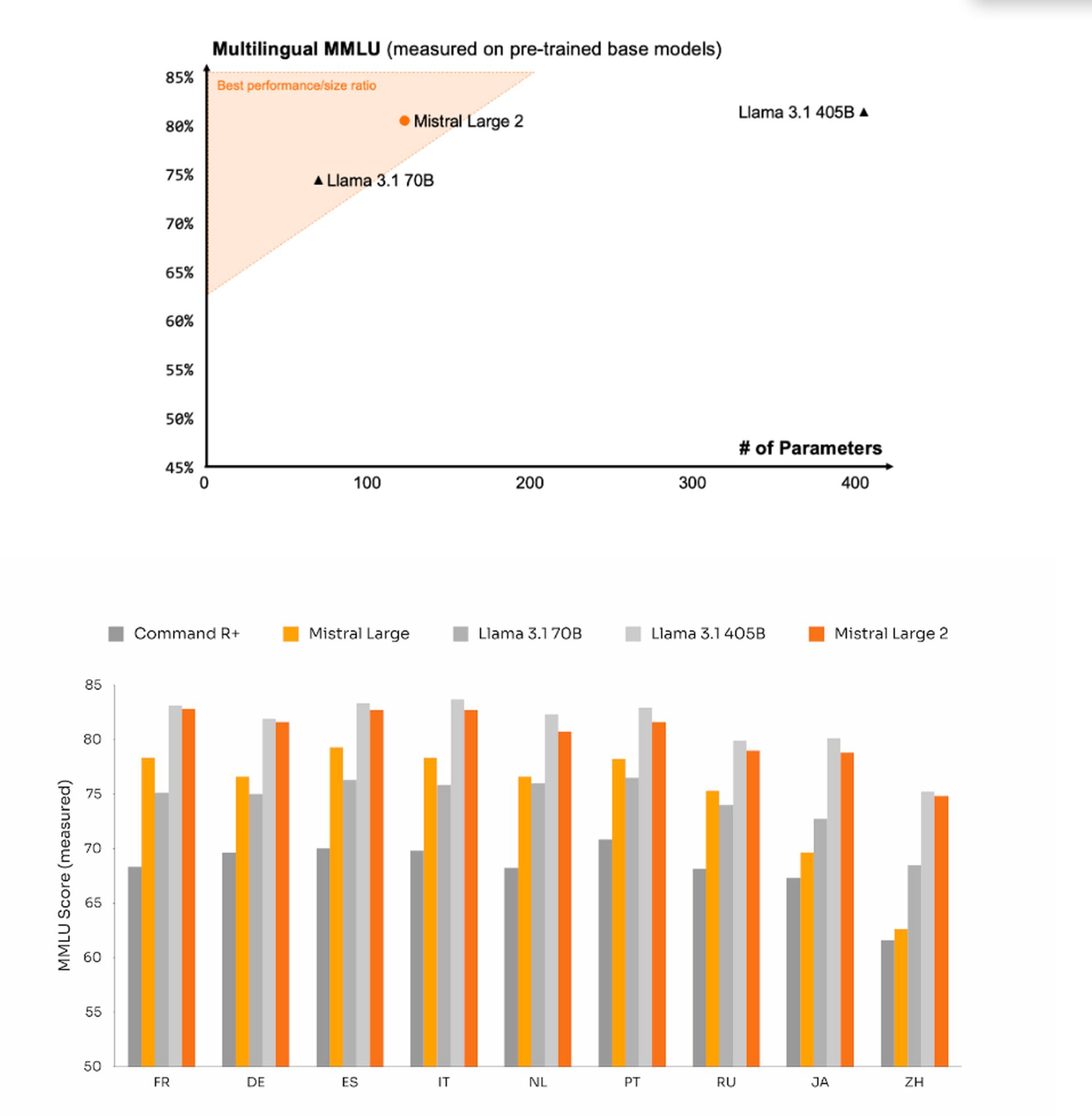

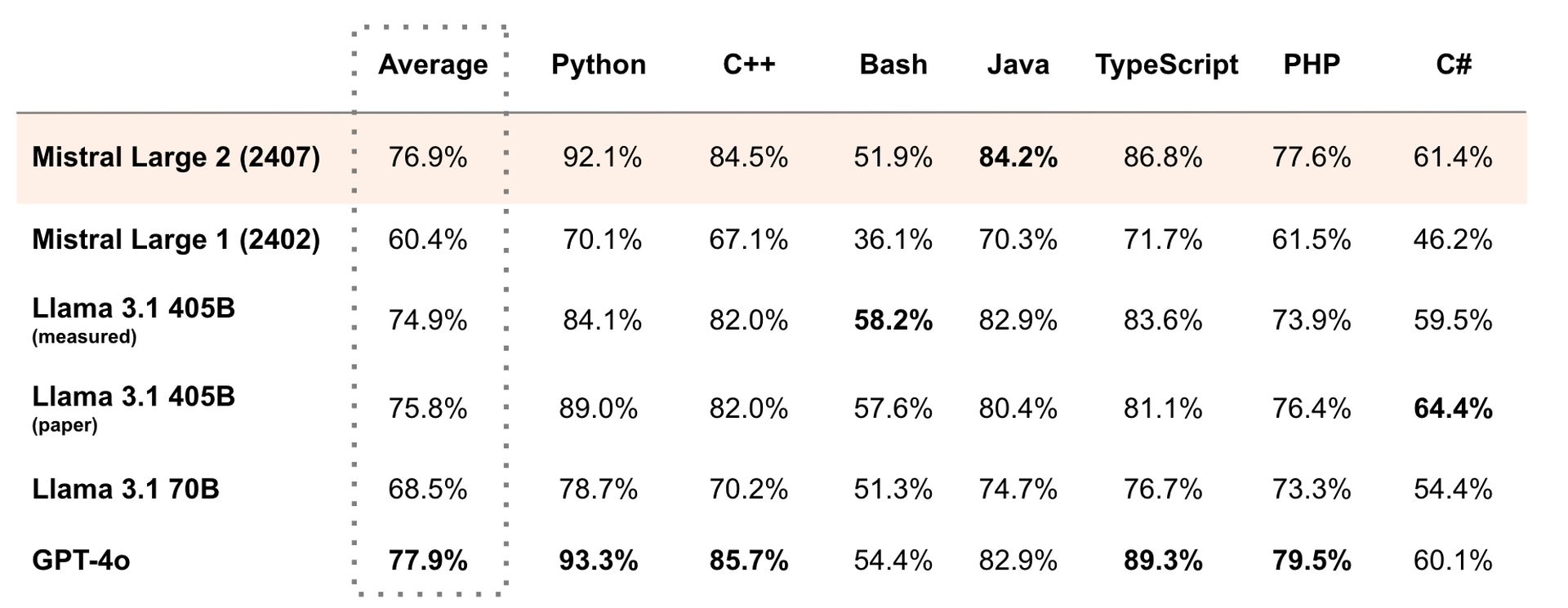

Mistral Large 2 hat bei verschiedenen Benchmarks eine starke Leistung bewiesen:

- Kodierungsaufgaben: Beim HumanEval-Benchmark, der Programmierkenntnisse testet, zeigt Mistral Large 2 eine hohe Leistung und ist mit führenden Modellen wie GPT-4 vergleichbar. Dies weist auf seine Fähigkeit hin, Code effektiv zu verstehen und zu generieren.

- Mathematisches Problemlösen: Das Modell schneidet im MATH-Benchmark, der mathematische Problemlösungsfähigkeiten bewertet, gut ab. Obwohl es knapp hinter GPT-4 liegt, spiegelt seine Leistung seine Fähigkeit wider, komplexe Berechnungen und logische Aufgaben zu bewältigen.

- Mehrsprachige Leistung: Im mehrsprachigen MMLU-Test zeichnet sich Mistral Large 2 in mehreren Sprachen aus und zeigt seine Fähigkeit, Text in verschiedenen sprachlichen Kontexten zu verarbeiten und zu generieren.

Technische Spezifikationen

Mistral Large 2 ist so konzipiert, dass es trotz seines großen Umfangs effizient arbeitet. Es kann auf einer einzigen Maschine ausgeführt werden, was angesichts seiner Größe von Bedeutung ist. Diese Effizienz ist für Anwendungen von Vorteil, bei denen große Textmengen schnell verarbeitet werden müssen.

Codierungsfunktionen

Das Modell unterstützt über 80 Programmiersprachen, darunter beliebte wie Python, Java, C, C++, JavaScript und Bash. Diese umfassende Unterstützung ist das Ergebnis einer umfassenden Schulung mit Schwerpunkt auf Programmieraufgaben und macht Mistral Large 2 zu einem vielseitigen Tool für Entwickler und alle, die mit Code arbeiten.

Mehrsprachigkeit

Mistral Large 2 kann Text in zahlreichen Sprachen verarbeiten und generieren, darunter:

- Europäische Sprachen: Französisch, Deutsch, Spanisch, Italienisch, Portugiesisch

- Asiatische Sprachen: Arabisch, Hindi, Russisch, Chinesisch, Japanisch, Koreanisch

Diese umfassende Sprachenunterstützung ermöglicht es dem Modell, verschiedene mehrsprachige Aufgaben und Anwendungen zu bewältigen.

Der fehlende Teil

Mistral Large 2 bietet derzeit keine multimodalen Funktionen, bei denen sowohl Text als auch Bilder gleichzeitig verarbeitet werden. Dies ist ein Bereich, in dem andere Modelle, wie die von OpenAI, derzeit im Vorteil sind. Zukünftige Entwicklungen könnten diese Lücke schließen.

So verwenden Sie Mistral Large 2

Mistral Large 2 ist über mehrere Plattformen verfügbar, darunter:

Zum Experimentieren bietet Mistral auch Zugriff über seinen ChatGPT-Konkurrenten le Chat an. Obwohl das Modell zugänglicher ist als einige Konkurrenten, ist es nicht Open Source und für die kommerzielle Nutzung ist eine kostenpflichtige Lizenz erforderlich.

Ist das neue Modell Large 2 von Mistral also groß genug?

Mistrals Large 2-Modell ist mit 123 Milliarden Parametern tatsächlich ziemlich groß und damit eines der umfangreichsten verfügbaren Sprachmodelle. Dieser Umfang ermöglicht es ihm, komplexe Textgenerierungsaufgaben zu bewältigen und die Kohärenz über lange Passagen hinweg aufrechtzuerhalten. Sein Kontextfenster mit 128.000 Token verbessert seine Fähigkeit, detaillierte und lange Dokumente zu verarbeiten und zu generieren, noch weiter.

Zusätzlich zu seiner schieren Größe wurde Mistral Large 2 optimiert, um Probleme wie die Generierung falscher Informationen zu minimieren und seine Zuverlässigkeit zu verbessern. Es schneidet auch bei verschiedenen Benchmarks gut ab, darunter bei Codierung und mathematischer Problemlösung, und unterstützt mehrere Sprachen. Also ja, Mistral Large 2 ist beeindruckend groß und leistungsfähig und erfüllt die Anforderungen vieler fortschrittlicher KI-Anwendungen.

Source: Ist das neue Modell Large 2 von Mistral groß genug?