Microsoft hat rollt eine spannende Neuentwicklung im Bereich der Sprachmodelle: das 1-Bit-LLM. Dieser Fortschritt, inspiriert von Forschungsprojekten wie BitNetmarkiert einen bemerkenswerten Wandel in der Art und Weise, wie Sprachmodelle konstruiert und optimiert werden. Das Herzstück dieser Innovation ist eine äußerst effiziente Methode zur Darstellung von Modellparametern – oder Gewichten.mit nur 1,58 Bit, im Gegensatz zum herkömmlichen 16-Bit-Gleitkomma (FP16) Ansatz, der in früheren Modellen vorherrschte.

Der erste 1-Bit-LLM seiner Art

Synchronisiert BitNet LLM b1.58Dieser bahnbrechende Ansatz begrenzt die potenziellen Werte jedes Gewichts auf nur drei Optionen: -1, 0 oder +1. Diese drastische Reduzierung der Anzahl der pro Parameter erforderlichen Bits bildet den Grundstein für diese bahnbrechende Technologie. Überraschenderweise schafft BitNet b1.58 trotz seines geringen Bitverbrauchs dies liefern Leistungskennzahlen, die mit denen herkömmlicher Modelle vergleichbar sind. Dies umfasst Bereiche wie Ratlosigkeit und Endaufgabenleistung, wobei alle dieselben Größen und Trainingsdatensätze verwendet werden.

Was sind 1-Bit-LLMs?

Die generative KI-Szene entwickelt sich von Tag zu Tag weiter, und der jüngste Durchbruch in diesem dynamischen Bereich ist die Einführung von 1-Bit-Sprachlernmodellen. Es mag überraschend klingen, aber diese Entwicklung hat das Potenzial, den KI-Bereich zu verändern, indem sie einige der größten Hürden beseitigt, mit denen LLMs heute konfrontiert sind:nämlich ihre gigantische Größe.

Typischerweise werden die Gewichte eines maschinellen Lernmodells, sei es ein LLM oder etwas so Einfaches wie die logistische Regression, mit einem der beiden gespeichert 32-Bit- oder 16-Bit-Gleitkommazahlen. Dieser Standardansatz ist ein zweischneidiges Schwert; Dies ermöglicht zwar eine hohe Präzision bei den Modellberechnungen, führt aber auch zu der immensen Größe dieser Modelle.

Diese Aufblähung ist genau der Grund, warum die Bereitstellung von Schwergewichts-Champions wie GPT auf lokalen Systemen oder in Produktionsumgebungen zu einem logistischen Albtraum wird. Ihre astronomische Anzahl an Gewichten, die durch die Präzision dieser Gleitkommazahlen erforderlich ist, lässt ihre Größe in unüberschaubare Ausmaße wachsen.

Im krassen Gegensatz zu den traditionellen Modellen, 1-Bit-LLMs verwenden nur ein einziges Bit – entweder 0 oder 1 – zur Darstellung von Gewichtsparametern. Diese scheinbar geringfügige Änderung hat große Auswirkungen: Sie reduziert die Gesamtgröße der Modelle drastisch, möglicherweise um ein Vielfaches.

Eine solche Größenreduzierung eröffnet den Weg für den Einsatz von LLMs auf viel kleineren Gerätenwodurch fortgeschrittene KI-Anwendungen mehr werden auf einer breiteren Palette von Plattformen zugänglich und machbar.

Zurück zu BitNet LLM b1.58

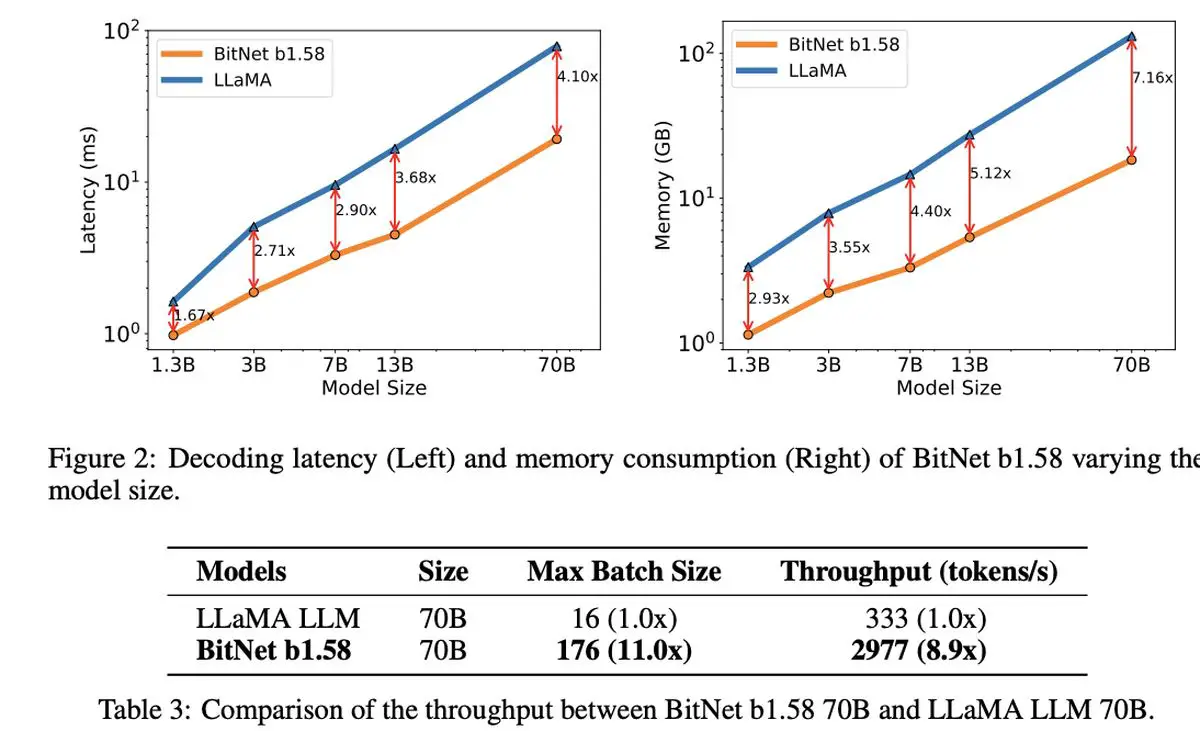

Das wirklich Bemerkenswerte am 1,58-Bit-LLM ist seine Kosteneffektivität. Das Modell glänzt durch reduzierte Latenz, geringere Speichernutzung, verbesserten Durchsatz und geringeren Energieverbrauch und stellt eine nachhaltige Option in der rechenintensiven Welt der KI dar.

Microsofts 1-Bit-LLM zeichnet sich nicht nur durch seine Effizienz aus. Es stellt eine neue Perspektive auf die Skalierung und das Training von Sprachmodellen dar und bringt erstklassige Leistung mit wirtschaftlicher Rentabilität in Einklang. Es deutet auf den Beginn neuer Computerparadigmen und die Möglichkeit hin, spezielle Hardware zu entwickeln, die auf den Betrieb dieser schlankeren, effizienteren Modelle zugeschnitten ist.

Auch die Diskussion um BitNet LLM b1.58 wird eröffnet faszinierende Möglichkeiten, lange Sequenzen in LLMs effektiver zu verwaltenund schlägt potenzielle Bereiche für weitere Forschung vor in verlustfreien Komprimierungstechniken, um die Effizienz noch weiter zu steigern.

Im Schatten dieser bemerkenswerten Innovation hat Microsoft auch mit seinem neuesten kleinen Sprachmodell, Phi-2, für Aufsehen gesorgt. Dieses Kraftpaket mit 2,7 Milliarden Parametern hat außergewöhnliche Fähigkeiten im Verstehen und Denken gezeigt, ein weiterer Beweis für Microsofts anhaltendes Engagement, die Grenzen der KI-Technologie zu verschieben. Die Einführung des 1-Bit-LLM würde zusammen mit dem Erfolg von Phi-2 eine aufregende Ära der Innovation und Effizienz in der Sprachmodellentwicklung einläuten.

Hervorgehobener Bildnachweis: Drew Beamer/Unsplash

Source: Microsoft stellt sein 1-Bit-LLM vor