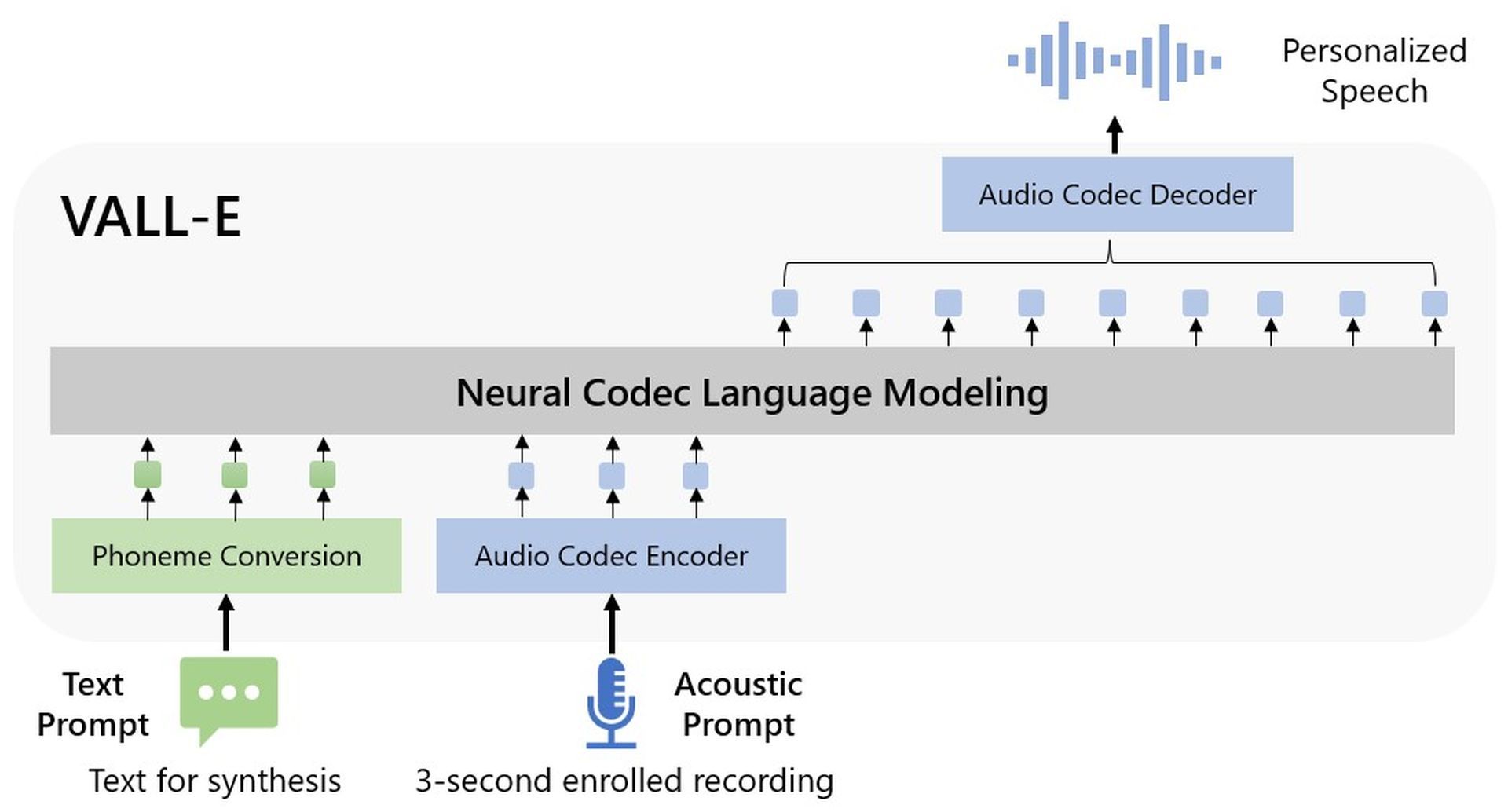

Microsofts Übernahme von Text-zu-Sprache-Synthese, Microsoft VALL-E, wurde in a angekündigt von der Gesellschaft herausgegebenes Papier. Das Audiomodell benötigt nur eine 3-Sekunden-Audiodatei, um die gegebene Eingabe zu verarbeiten.

Microsoft VALL-E, ein neuartiger Sprachmodellansatz für die Text-zu-Sprache-Synthese (TTS), der Audio-Codec-Codes als Zwischendarstellungen nutzt, wurde gerade von Microsoft eingeführt. Es wurde mit 60.000 Stunden englischer Sprachdaten vortrainiert und zeigte dann kontextbezogene Lernfähigkeiten unter Zero-Shot-Umständen.

Microsoft VALL-E kann qualitativ hochwertige personalisierte Sprache mit nur einer dreisekündigen registrierten Aufnahme eines schrägen Sprechers erzeugen, der als akustischer Stimulus dient. Dies geschieht ohne die Notwendigkeit zusätzlicher Konstruktionstechnik, vorgefertigter akustischer Merkmale oder Feinabstimmung. Es unterstützt kontextbezogenes Lernen und Prompt-basierte Zero-Shot-TTS-Ansätze. Es scheint, dass das Hochskalieren von halbüberwachten Daten für TTS zu wenig genutzt wurde, weil Microsoft eine beträchtliche Menge von halbüberwachten Daten verwendet hat, um ein verallgemeinertes TTS-System in der Sprecherdimension zu konstruieren.

Was können Sie mit Microsoft VALL-E tun?

Laut den Forschern ist Microsoft VALL-E ein „neuronales Codec-Sprachmodell“, das mit diskreten Codes trainiert wurde, die „von einem bereits bestehenden neuronalen Audio-Codec-Modell abgeleitet“ wurden. Es wurde mit 60.000 Sprachstunden trainiert, was laut Aussage „hundertmal mehr ist als bestehende Systeme“. Diese Beispiele überzeugen im Gegensatz zu früheren Versuchen, die ganz offensichtlich Roboter sind, obwohl es schon eine Weile KI gibt, die menschliche Sprache realistisch nachahmen kann.

Microsoft VALL-E kann laut den Forschern der Aufforderung „die Emotionen und die auditive Umgebung des Sprechers bewahren“. Obwohl es beeindruckend ist, ist die Technologie noch weit davon entfernt, Synchronsprecher zu ersetzen, da es anders ist, den richtigen Ton und die richtige Emotion während einer Aufführung zu finden. Selbst eine fortgeschrittene Version von Microsoft VALL-E wäre nicht in der Lage, so gut zu funktionieren wie ein erfahrener Fachmann, dennoch geben Unternehmen häufig der Kosteneffizienz Vorrang vor der Qualität.

Auf GitHub-Demo von Microsoftkönnen Sie sich einige Beispiele anhören.

Microsoft VALL-E-Funktionen

Obwohl Microsoft VALL-E sehr neu ist, hat es bereits viele Funktionen.

Synthese der VielfaltHinweis: Da Microsoft VALL-E diskrete Token mithilfe der Sampling-basierten Technik generiert, variiert die Ausgabe für denselben Eingabetext. Es kann daher verschiedene personalisierte Sprachproben unter Verwendung einer Vielzahl von zufälligen Startwerten synthetisieren.

Wartung der akustischen Umgebung: Microsoft VALL-E kann angepasste Sprache bereitstellen, während die akustische Umgebung der Lautsprecheransage beibehalten wird. Im Vergleich zur Baseline wird VALL-E auf einem großen Datensatz mit mehr akustischen Variablen trainiert. Audio und Transkriptionen wurden unter Verwendung von Proben aus dem Fisher-Datensatz erstellt.

Emotionserhaltung des Sprechers: Unter Verwendung der Emotional Voices Database als Ressource für beispielsweise Audioaufforderungen kann Microsoft VALL-E angepasste Sprache erstellen, während der emotionale Tenor der Sprecheraufforderung beibehalten wird. Herkömmliche Ansätze trainieren ein Modell, indem sie die Sprache mit der Transkription und einem Emotionslabel in einem überwachten emotionalen TTS-Datensatz korrelieren. VALL-E kann die Emotion auch in einer Nullschuss-Situation in der Eingabeaufforderung halten.

Microsoft VALL-E hat immer noch Probleme mit der Modellstruktur, der Datenabdeckung und der Robustheit der Synthese.

Wie funktioniert Microsoft WALL-E?

Microsoft verwendete LibriLight, eine von Meta zusammengestellte Audiobibliothek, um die Synthesefähigkeiten von VALL-voice E zu trainieren. Der Großteil der 60.000 Stunden englischsprachiger Sprache stammt aus den gemeinfreien Hörbüchern von LibriVox und wird von mehr als 7.000 verschiedenen Menschen gesprochen. Die Stimme im dreisekündigen Beispiel muss einer Stimme in den Trainingsdaten sehr ähnlich sein, damit VALL-E ein zufriedenstellendes Ergebnis erzielt.

Microsoft bietet auf der VALL-E-Beispielseite Dutzende Audiobeispiele des KI-Modells in Aktion. Der „Speaker Prompt“, eines der Samples, sind die drei Sekunden Audio, die VALL-E nachahmen soll. Die „Ground Truth“ ist ein zuvor aufgenommener Ausschnitt dieses Sprechers, der als Benchmark verwendet wird (ähnlich wie die „Kontrolle“ im Experiment). Das „VALL-E“-Beispiel ist die Ausgabe des VALL-E-Modells, und das „Baseline“-Beispiel ist ein Synthesebeispiel, das durch einen traditionellen Text-zu-Sprache-Syntheseansatz erzeugt wird.

Während Microsoft VALL-E als erstes, aber sicherlich nicht letztes, großes KI-Projekt des Jahres 2023 Geschichte schrieb, unterstützte der Technologieriese OpenAI Point-E, das in den letzten Wochen des Jahres 2022 veröffentlicht wurde, finanziell.

Source: Microsoft VALL-E erklärt: Ein Voice DALL-E