Nvidia revolutioniert die Welt der künstlichen Intelligenz die kürzliche Einführung des NVIDIA H200. Diese hochmoderne Plattform ist darauf aufgebaut der NVIDIA Hopper Architektur, verfügt über die leistungsstarke NVIDIA H200 Tensor Core GPU, ausgestattet mit Erweitertes Gedächtnis zum Anpacken konzipiert erhebliche Datenmengen für generative KI und High-Performance-Computing (HPC)-Workloads.

Architektur, verfügt über die leistungsstarke NVIDIA H200 Tensor Core GPU, ausgestattet mit Erweitertes Gedächtnis zum Anpacken konzipiert erhebliche Datenmengen für generative KI und High-Performance-Computing (HPC)-Workloads.

In diesem Artikel gehen wir näher auf die jüngste Markteinführung ein und geben so viele Details wie möglich über die neue NVIDIA H200.

Die Leistung von NVIDIA H200

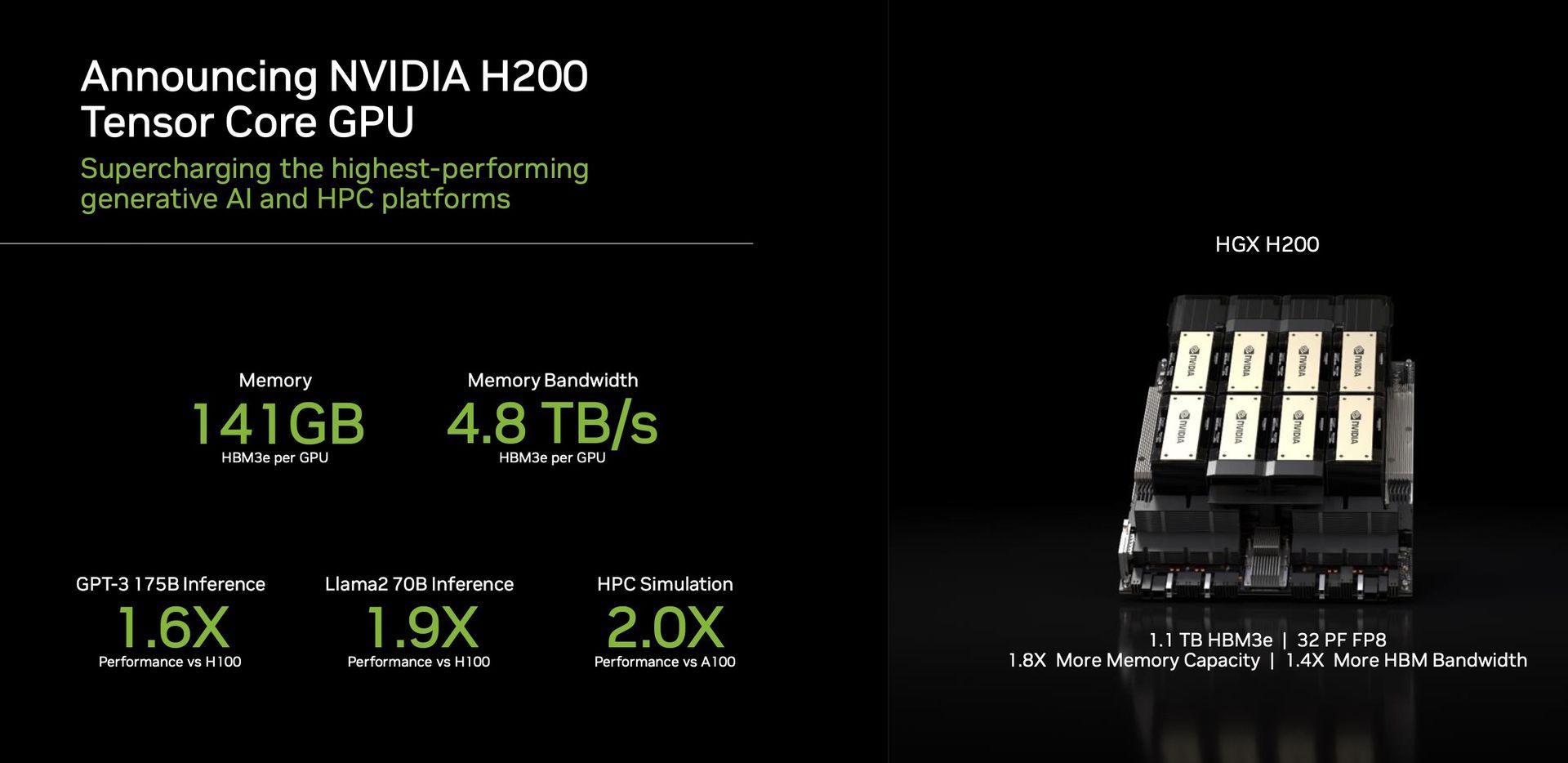

Ein herausragendes Merkmal des H200 ist seine Nutzung von HBM3e, die erste GPU, die diesen schnelleren und größeren Speicher bietet. Dieser Fortschritt treibt die Beschleunigung generativer KI und großer Sprachmodelle voran und verschiebt gleichzeitig die Grenzen von Wissenschaftliches rechnen für HPC-Workloads. Mit HBM3e liefert der H200 eine beeindruckende Leistung 141 GB Speicher auf atemberaubende Weise 4,8 Terabyte pro Sekunde. Dies entspricht nahezu der doppelten Kapazität und 2,4-mal mehr Bandbreite im Vergleich zum Vorgänger, die NVIDIA A100.

Leistung und Anwendungen

Der H200, angetrieben von NVIDIA NVLink und NVSwitch

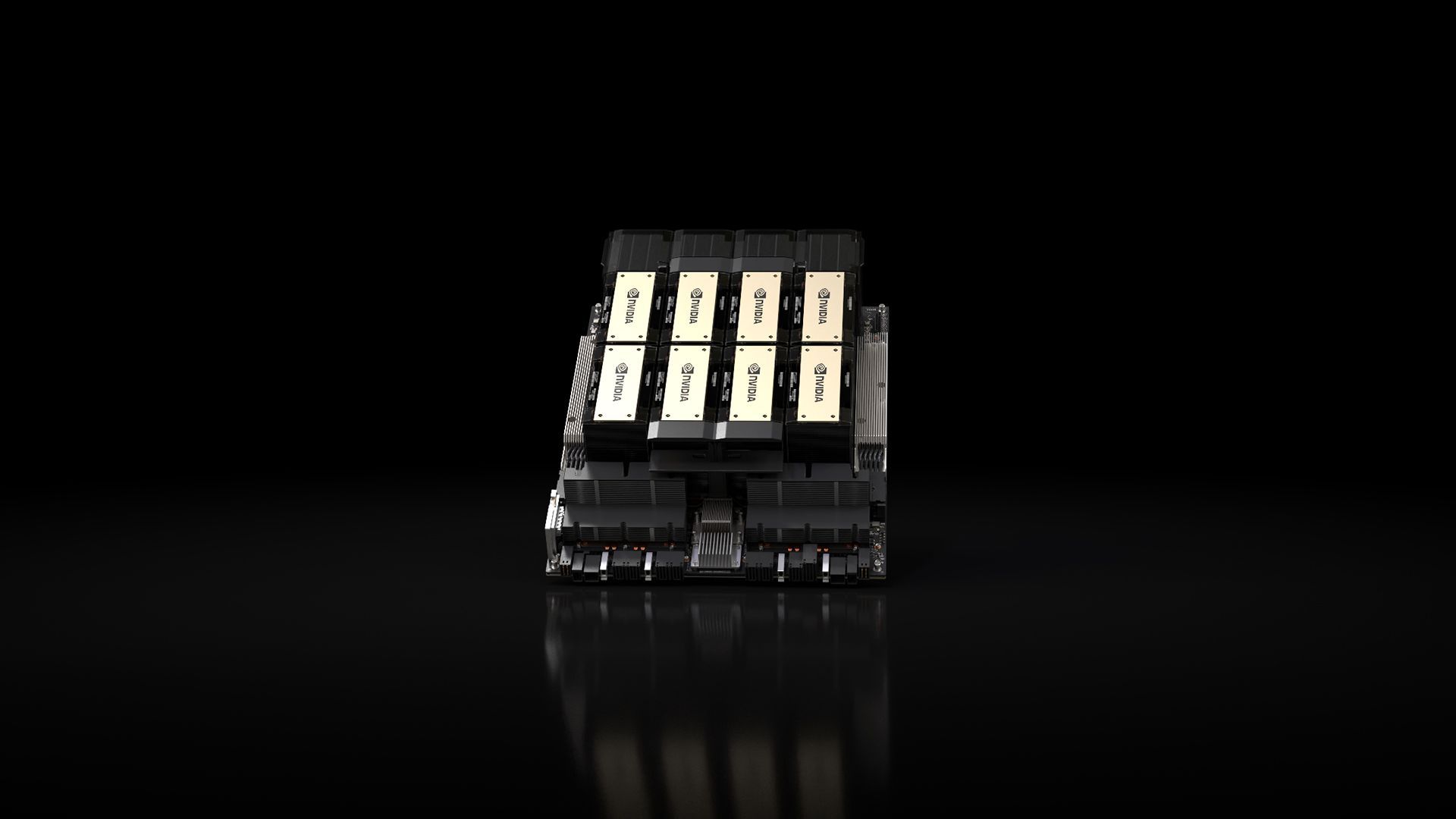

und NVSwitch Hochgeschwindigkeitsverbindungen, Versprechen beispiellose Leistung über verschiedene Anwendungs-Workloads hinweg. Dazu gehören seine Kompetenzen im LLM-Training (Large Language Model) und in der Inferenz für Modelle, die über eine kolossale Größe hinausgehen 175 Milliarden Parameter. Ein achtfacher HGX H200 zeichnet sich dadurch aus, dass er mehr bietet 32 Petaflops FP8 tief Computer lernen Und ein Gesamtspeicher mit hoher Bandbreite von 1,1 TB, Gewährleistung der Spitzenleistung in generativen KI- und HPC-Anwendungen.

Hochgeschwindigkeitsverbindungen, Versprechen beispiellose Leistung über verschiedene Anwendungs-Workloads hinweg. Dazu gehören seine Kompetenzen im LLM-Training (Large Language Model) und in der Inferenz für Modelle, die über eine kolossale Größe hinausgehen 175 Milliarden Parameter. Ein achtfacher HGX H200 zeichnet sich dadurch aus, dass er mehr bietet 32 Petaflops FP8 tief Computer lernen Und ein Gesamtspeicher mit hoher Bandbreite von 1,1 TB, Gewährleistung der Spitzenleistung in generativen KI- und HPC-Anwendungen.

Nvidias GPUs sind geworden ausschlaggebend im Bereich generativer KI-Modelle und spielen eine entscheidende Rolle bei deren Entwicklung und Einsatz. Die GPUs von Nvidia sind für die Bewältigung umfangreicher paralleler Berechnungen ausgelegt, die für das Training und den Betrieb dieser Modelle erforderlich sind, und zeichnen sich bei Aufgaben wie z Bilderzeugung Und Natürliche Sprache wird bearbeitet. Die parallele Verarbeitungsarchitektur ermöglicht die Leistung dieser GPUs zahlreiche Berechnungen gleichzeitig, Dies führt zu einer erheblichen Beschleunigung generativer KI-Modellprozesse.

Der H200 ist ein Beweis für das Engagement von Nvidia ständige Innovation und Leistungssprünge. Aufbauend auf dem Erfolg der Hopper-Architektur werden laufende Softwareverbesserungen, einschließlich der jüngsten Veröffentlichung von Open-Source-Bibliotheken wie NVIDIA TensorRT -LLM, die Leistung der Plattform weiter steigern. Die Einführung von NVIDIA H200 verspricht weitere Sprünge, mit Erwartungen von fast Verdoppelung der Inferenzgeschwindigkeit bei Modellen wie Llama 2, einem LLM mit 70 Milliarden Parametern, im Vergleich zu seinem Vorgänger, dem H100.

-LLM, die Leistung der Plattform weiter steigern. Die Einführung von NVIDIA H200 verspricht weitere Sprünge, mit Erwartungen von fast Verdoppelung der Inferenzgeschwindigkeit bei Modellen wie Llama 2, einem LLM mit 70 Milliarden Parametern, im Vergleich zu seinem Vorgänger, dem H100.

Vielseitigkeit und Verfügbarkeit

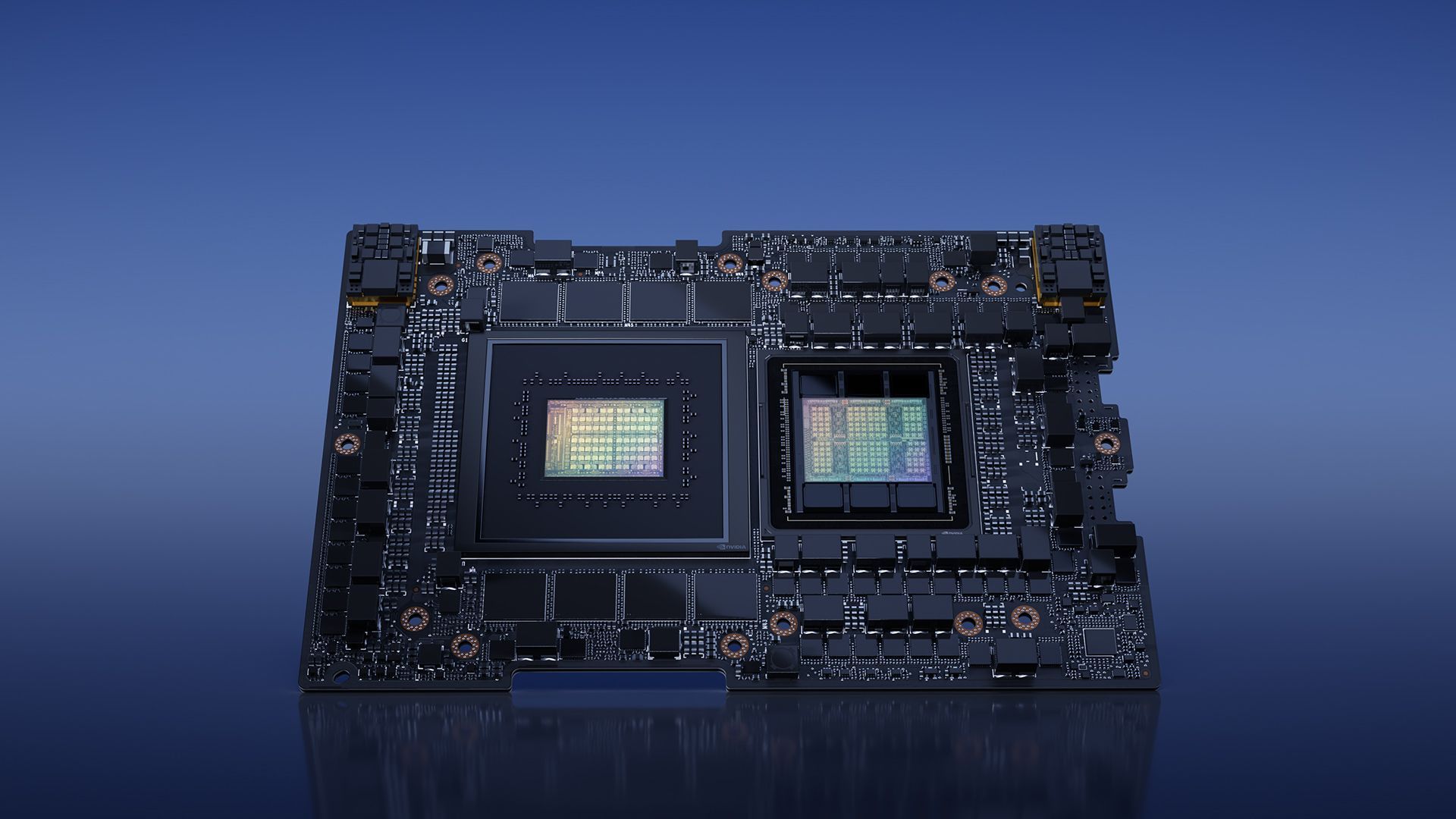

Nvidia sorgt dafür Vielseitigkeit mit dem H200 und bietet ihn in verschiedenen Formfaktoren an, beispielsweise als NVIDIA HGX H200-Serverboards mit Vier- und Acht-Wege-Konfigurationen. Diese Konfigurationen sind sowohl mit der Hardware als auch mit der Software der HGX H100-Systeme kompatibel. Darüber hinaus ist NVIDIA H200 verfügbar in der NVIDIA GH200 Grace Hopper Superchip mit HBM3e für verschiedene Rechenzentrumskonfigurationen, einschließlich lokaler, Cloud-, Hybrid-Cloud- und Edge-Umgebungen. Das globale Ökosystem von Partnerserverherstellern kann ihre bestehenden Systeme nahtlos aktualisieren mit dem H200 und gewährleistet so eine flächendeckende Zugänglichkeit.

Superchip mit HBM3e für verschiedene Rechenzentrumskonfigurationen, einschließlich lokaler, Cloud-, Hybrid-Cloud- und Edge-Umgebungen. Das globale Ökosystem von Partnerserverherstellern kann ihre bestehenden Systeme nahtlos aktualisieren mit dem H200 und gewährleistet so eine flächendeckende Zugänglichkeit.

Enthusiasten und Branchenexperten warten gespannt auf die Veröffentlichung der HGX H200-Systeme, die voraussichtlich im Jahr auf den Markt kommen das zweite Quartal 2024. Prominente Global Player wie z.B Amazon Web Services, Google Cloud, Microsoft Azure, Und Oracle Cloud-Infrastruktur gehören dazu die erste Welle von Cloud-Dienstanbietern bereit, im nächsten Jahr H200-basierte Instanzen bereitzustellen.

die Architektur (Bildnachweis)

die Architektur (Bildnachweis)Zusammenfassend lässt sich sagen, dass der NVIDIA H200 mit seinen bahnbrechenden Funktionen und Leistungsfähigkeiten auf dem richtigen Weg ist Definieren Sie die Landschaft des KI-Computings neu. Da der H200 im zweiten Quartal 2024 verfügbar sein wird, ist er bereit, Entwicklern und Unternehmen auf der ganzen Welt mehr Möglichkeiten zu bieten. Beschleunigung der Entwicklung und Bereitstellung von KI-Anwendungen von der Sprache zur Hyperscale-Inferenz.

Wenn Sie sich in der Zwischenzeit für das führende Technologieunternehmen interessieren, lesen Sie unbedingt auch unseren Artikel darüber, wie Nvidia und AMD an einem „Arm-basierten Chip“ arbeiten.

Hervorgehobener Bildnachweis: NVIDIA

Source: NVIDIA H200 wird mit großer Vorfreude im KI-Bereich eingeführt