OpenAI hat Echtzeit-Videofunktionen für ChatGPT eingeführt und visuelle Funktionsfunktionen in seinen erweiterten Sprachmodus integriert. Diese Ankündigung erfolgte während einer Livestream-Veranstaltung am 12. Dezember 2024. Die aktualisierte Version kann Objekte in Echtzeit über die Gerätekamera des Benutzers erkennen, visuelle Informationen über die Bildschirmfreigabe verarbeiten und an menschenähnlichen Gesprächen teilnehmen. Das Update ist für Abonnenten von ChatGPT Plus, Team und Pro verfügbar und wird im Laufe der nächsten Woche eingeführt, wobei einige Benutzer in der EU mit möglichen Verzögerungen rechnen müssen.

Mit dieser Erweiterung kann ChatGPT auf Benutzer reagieren, indem es das, was es sieht, interpretiert, z. B. Erklärungen zu Einstellungen auf einem Gerät oder Vorschläge zur Lösung mathematischer Probleme. Um diese Funktionen zu nutzen, können Benutzer in der ChatGPT-App auf das Sprachsymbol tippen und die Video- oder Bildschirmfreigabe aktivieren. Der Rollout hat für Plus-Abonnenten Vorrang, während ChatGPT Enterprise- und Edu-Benutzer im Januar 2025 Zugriff erhalten.

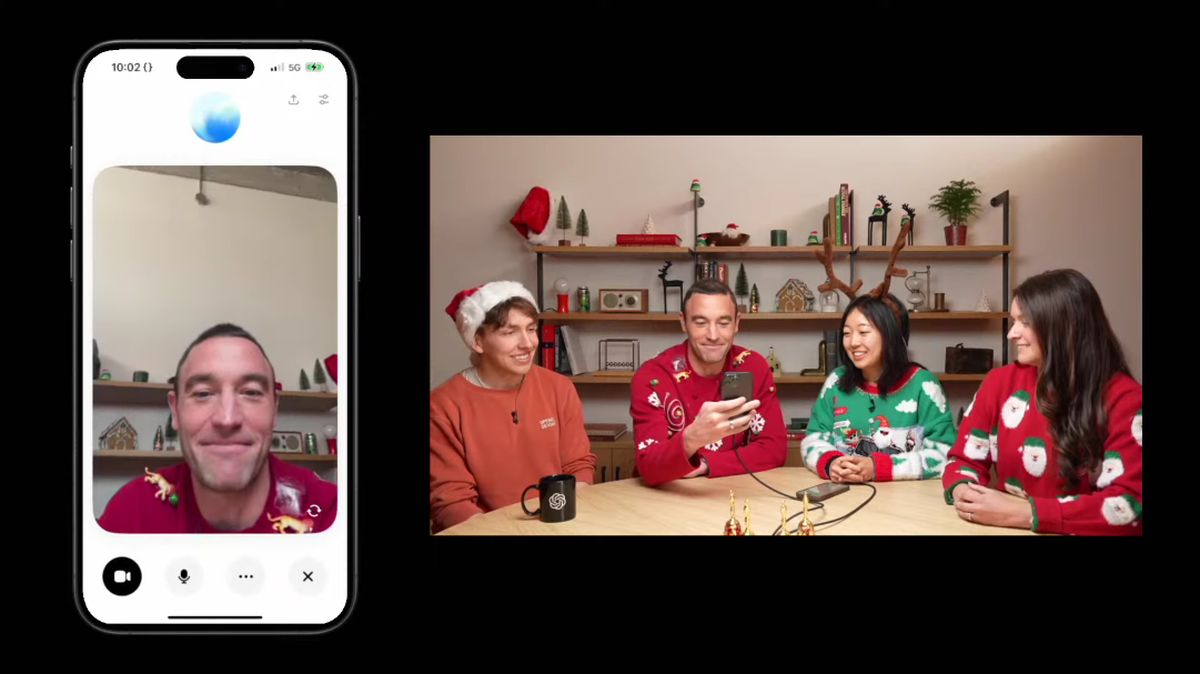

OpenAI präsentiert erweiterte Funktionen in einer Live-Demonstration

Während der jüngsten Live-Demonstration hob OpenAI-Präsident Greg Brockman die fesselnden Fähigkeiten des Advanced Voice Mode mit Weitblick hervor. Brockman befragte Anderson Cooper von CNN zum Thema Anatomie und demonstrierte gleichzeitig, wie ChatGPT Zeichnungen von Cooper auf einer Tafel verstehen und kommentieren konnte. Die Interaktion verdeutlichte das Potenzial für interaktives Lernen und Feedback in Echtzeit, obwohl ChatGPT einige Fehler aufwies, wie z. B. die Fehlberechnung eines Geometrieproblems, was die anhaltenden Herausforderungen im Zusammenhang mit der Modellgenauigkeit verdeutlichte.

Bei dieser aktualisierten Funktion kam es zu Verzögerungen bei der Entwicklung, da OpenAI zuvor auf Startfenster hingewiesen hatte, die letztlich verlängert wurden. Der erweiterte Sprachmodus wurde ursprünglich im Mai 2024 vorgestellt und sollte früher verfügbar sein. Die jüngste Ankündigung stellt den Höhepunkt der Bemühungen dar, diese Funktion zu verfeinern und zu finalisieren, und weist auf einen strategischen Fokus auf die Verbesserung der Benutzererfahrung und der technologischen Fähigkeiten des Chatbots hin.

Zusätzlich zu den neuen visuellen Funktionalitäten hat OpenAI auch einen „Santa Mode“ für die Weihnachtszeit vorgestellt, der es Benutzern ermöglicht, in festlicher Atmosphäre mit ChatGPT zu interagieren. Um auf diese Funktion zuzugreifen, können Benutzer in der Anwendung auf das Schneeflockensymbol klicken. Diese saisonale Option setzt die Nutzungsbeschränkungen für die erste Interaktion zurück, sodass Benutzer mehr Gelegenheit haben, sich mit der festlichen Funktion zu beschäftigen.

Konkurrenten wie Google und Meta entwickeln ähnliche Funktionen, wie Googles Project Astra, das kürzlich ausgewählten Testern auf Android zur Verfügung gestellt wurde. Diese Bemühungen spiegeln einen breiteren Trend wider, bei dem große Technologieunternehmen daran arbeiten, interaktive Videofunktionen in ihre KI-Modelle zu integrieren und so die Benutzereinbindung und Anwendungsvielfalt zu verbessern.

OpenAI hat auch Pläne zur Einführung weiterer Verbesserungen angekündigt, beispielsweise zur Verstärkung seines Reinforcement Fine-Tuning Research Program, das darauf ausgelegt ist, die Modellleistung bei speziellen Aufgaben zu optimieren. Dieses Programm richtet sich an Forschungseinrichtungen und Unternehmen und ermöglicht ihnen die Anpassung von OpenAI-Modellen für komplexe Anwendungen.

Hervorgehobener Bildnachweis: OpenAI

Der Beitrag „OpenAI führt Echtzeit-Videofunktionen für ChatGPT ein“ erschien zuerst auf TechBriefly.

Source: OpenAI führt Echtzeit-Videofunktionen für ChatGPT ein