Basierend auf Texteingaben kann MusicGen von Meta kurze neue Musikkompositionen erstellen, die optional an eine bestehende Melodie angepasst werden können.

MusicGen basiert auf einem Transformer-Modell, wie auch die meisten heute verwendeten Sprachmodelle. MusicGen sagt den nächsten Abschnitt eines Musikstücks auf ähnliche Weise voraus, wie ein Sprachmodell die folgenden Buchstaben in einer Phrase vorhersagt. Die Forscher verwenden Metas EnCodec Audio-Tokenizer, um die Audiodaten in kleinere Teile zu zerlegen. MusicGen ist ein schneller und effektiver einstufiger Ansatz, der die Token-Verarbeitung parallel durchführt.

Zur Ausbildung wurde die Besatzung eingesetzt 20.000 Stunden autorisierter Musik. Sie benutzten 10.000 hochwertige Audioinhalte Aufnahmen aus einem internen Datensatz sowie insbesondere Musikdaten von Shutterstock und Pond5.

MusicGen: Was ist das?

Wie die meisten heute verwendeten Sprachmodelle wird MusicGen mithilfe eines Transformer-Modells erstellt. Ähnlich wie ein Sprachmodell die nachfolgenden Buchstaben in einem Satz vorhersagt, sagt MusicGen den folgenden Abschnitt eines Musikstücks voraus.

Die Audiodaten werden von den Forschern mithilfe des EnCodec-Audio-Tokenizers von Meta in kleinere Bits aufgeteilt. MusicGen ist eine einstufige Methode, die Token schnell und effektiv parallel verarbeitet.

Neben der Effizienz des Designs und der Produktionsgeschwindigkeit zeichnet sich MusicGen durch seine Fähigkeit aus, sowohl Text als auch musikalische Hinweise zu verwalten. Die Musik in der Audiodatei folgt dem im Text festgelegten Grundstil.

Man kann die Richtung der Melodie nicht genau ändern, um sie beispielsweise in anderen Musikrichtungen zu hören. Es dient nur als allgemeiner Leitfaden für die Generierung und wird in der Ausgabe nicht genau reproduziert.

Trotz der Tatsache, dass viele andere Modelle Textgenerierung, Sprachsynthese, generierte Bilder und sogar kleine Filme ausführen, gab es nicht viele qualitativ hochwertige Beispiele für Musikproduktion, die der Öffentlichkeit zugänglich gemacht wurden.

MusicGen: Wie benutzt man es?

Benutzer können MusicGen mit dem testen Hugging Face-API, Aber je nachdem, wie viele Benutzer es gleichzeitig verwenden, kann es einige Zeit dauern, Musik zu produzieren. Sie können Ihre eigene Instanz des Modells über die Hugging Face-Website erstellen, um schnellere Ergebnisse zu erzielen. Sie können den Code herunterladen und selbst ausführen, wenn Sie über die erforderlichen Kenntnisse und Tools verfügen.

So können Sie die Online-Version ausprobieren, wenn Sie, wie die meisten Menschen, Folgendes möchten:

- Start ein Webbrowser.

- Besuchen Sie die Webseite für Umarmendes Gesicht.

- Wählen Sie oben rechts aus Räume.

- Suchen nach „MusicGen“ In der Box.

- Suchen Sie diejenige, die Facebook veröffentlicht.

- Geben Sie im Feld links Ihre Eingabeaufforderung ein.

- Wählen “Generieren”.

Das ist alles, was Sie wissen müssen!

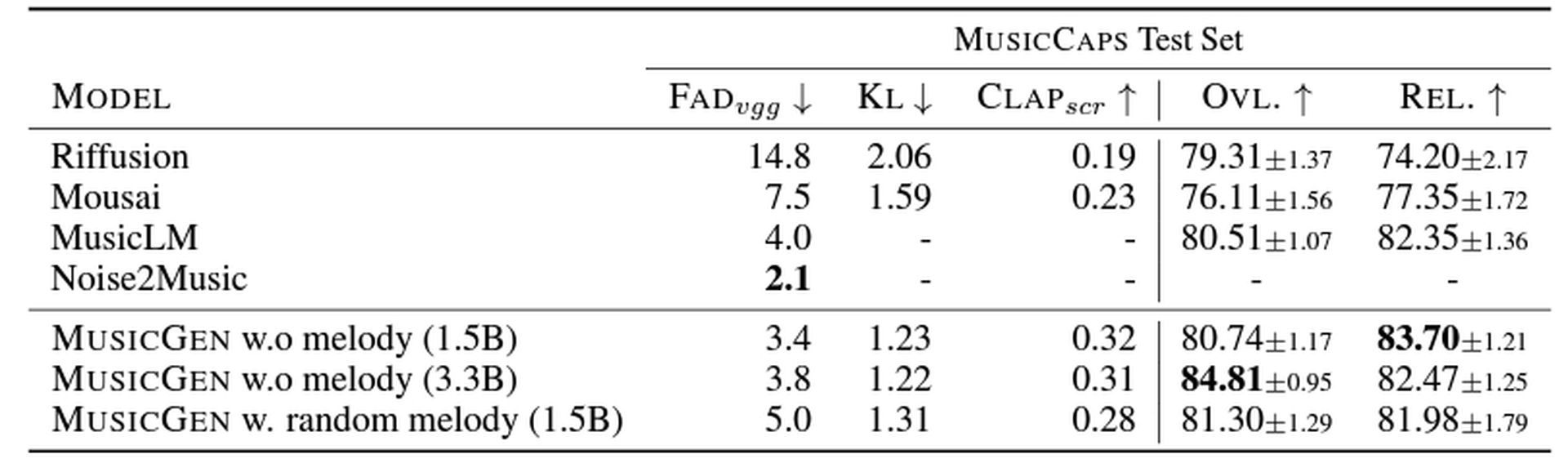

MusicGen schlägt MusicLM um Haaresbreite

Drei verschiedene Größen der Modell – 300 Millionen (300M), 1,5 Milliarden (1,5B), Und 3,3 Milliarden (3.3B) Parameter – wurden von den Autoren der Studie getestet. Der 1,5 Milliarden Das Parametermodell wurde von Menschen als das beste beurteilt, doch sie stellten fest, dass die größeren Modelle Klänge von höherer Qualität erzeugten. Andererseits ist die 3,3 Milliarden Das Parametermodell funktioniert korrekter, wenn die Texteingabe mit der Audioausgabe abgeglichen wird.

MusicGen schneidet im Vergleich zu anderen Musikmodellen wie Riffusion, Mousai, MusicLM und Noise2Music sowohl bei objektiven als auch bei subjektiven Messungen besser ab, die messen, wie gut die Musik zu den Worten passt und wie glaubwürdig die Komposition ist. Generell sind die Modelle etwas besser als Googles MusicLM.

Der Code und die Modelle wurden zur Verfügung gestellt von Meta als Open Source auf Github, kommerzielle Nutzung ist erlaubt. Es gibt eine Demo Umarmendes Gesicht.

Wissen Sie, was freigegebene ChatGPT-Links sind?

Source: Was ist Metas MusicGen und wie wird es verwendet?