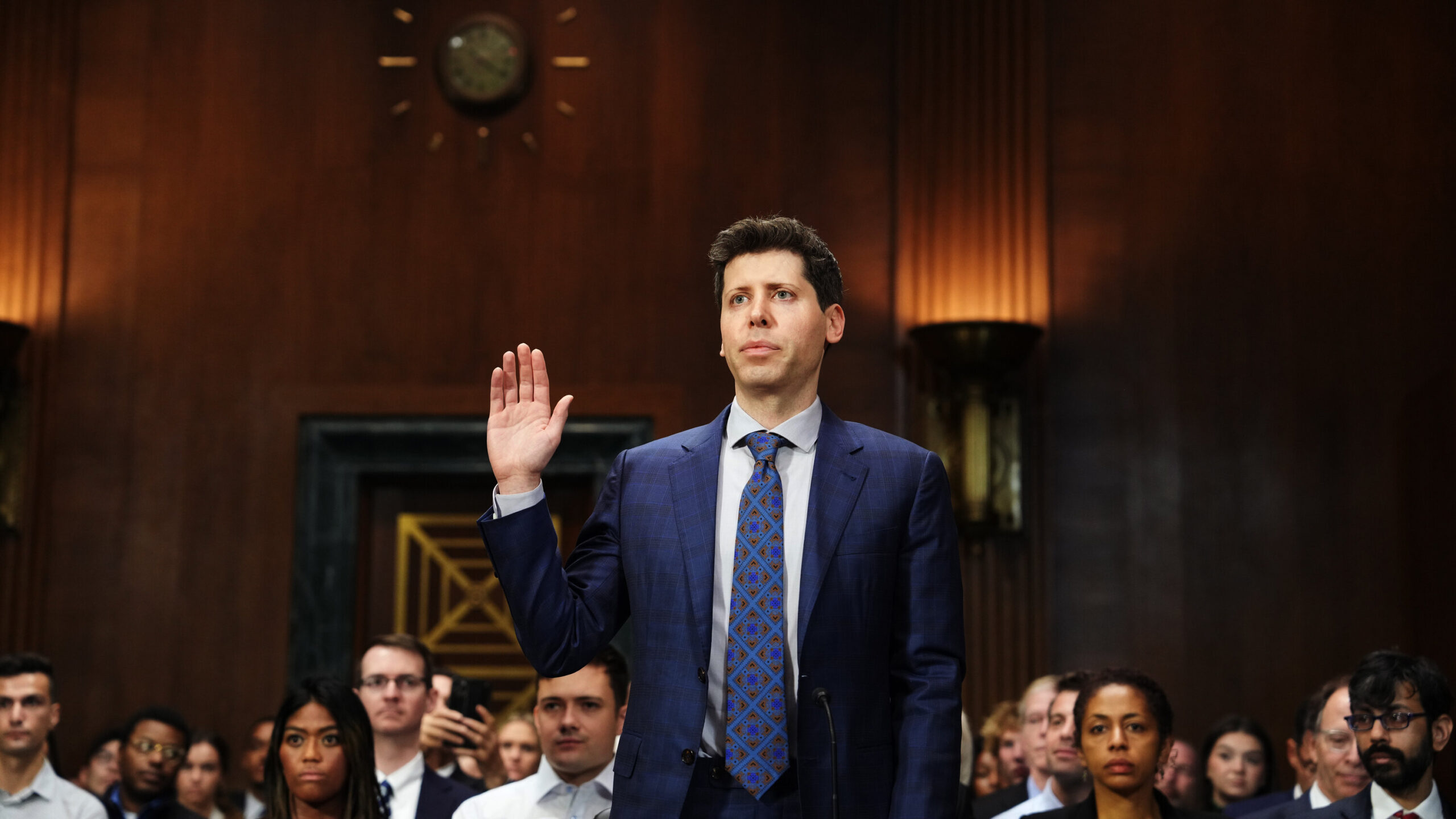

OpenAI-CEO Sam Altman setzt seine internationale Tätigkeit fort und baut dabei auf der Dynamik auf, die durch seine jüngsten Auftritte vor dem US-Kongress entstanden ist. Altmans Ansatz im Ausland unterscheidet sich jedoch vom KI-freundlichen Klima in den Vereinigten Staaten, da er auf die Möglichkeit hinweist, seine Technologieunternehmen zu verlagern, wenn die Einhaltung seiner Regeln nicht eingehalten wird.

Altmans Weltenbummlerreise hat ihn von hierher geführt Lagos, Nigeria zu verschiedenen europäischen Zielen und gipfelte in London, Vereinigtes Königreich. Trotz einiger Proteste tritt er aktiv mit prominenten Persönlichkeiten aus der Technologiebranche, Unternehmen und politischen Entscheidungsträgern in Kontakt und betont die Fähigkeiten des ChatGPT-Sprachmodells von OpenAI. Altman möchte Unterstützung für Pro-KI-Vorschriften gewinnen und gleichzeitig seine Unzufriedenheit über die Definition von „Hochrisiko“-Systemen durch die Europäische Union zum Ausdruck bringen, wie sie während einer Podiumsdiskussion am University College London diskutiert wurde.

Der Das von der Europäischen Union vorgeschlagene KI-Gesetz führt eine dreistufige Klassifizierung für KI-Systeme basierend auf Risikostufen ein. Beispiele für KI, die durch die Verletzung von Grundrechten ein „inakzeptables Risiko“ darstellen, sind unter anderem Social-Scoring-Systeme und manipulative Social-Engineering-KI. Andererseits müssen „Hochrisiko-KI-Systeme“ umfassende Transparenz- und Aufsichtsstandards einhalten, die auf ihren Verwendungszweck zugeschnitten sind.

Sam Altman äußerte Bedenken hinsichtlich des aktuellen Gesetzesentwurfs und erklärte, dass sowohl ChatGPT als auch das kommende GPT-4 möglicherweise in die Hochrisikokategorie fallen könnten. In solchen Fällen wäre die Einhaltung spezifischer Anforderungen erforderlich. Altman betonte die Absicht von OpenAI, sich um Compliance zu bemühen, räumte jedoch ein, dass es technische Einschränkungen gibt, die ihre Fähigkeit dazu beeinträchtigen könnten. Als berichtet von Time, erklärte er: „Wenn wir uns daran halten können, werden wir es tun, und wenn wir es nicht können, werden wir den Betrieb einstellen … Wir werden es versuchen.“ Aber es gibt technische Grenzen dessen, was möglich ist.“

Das KI-Gesetz der EU wird aktualisiert, da sich die KI weiter verbessert

Ursprünglich zielte das KI-Gesetz darauf ab, Bedenken im Zusammenhang mit Chinas Sozialkreditsystem und der Gesichtserkennung auszuräumen. Mit dem Aufkommen von OpenAI und anderen Start-ups ist das KI-Gesetz jedoch auf neue Herausforderungen gestoßen. Anschließend führte die EU im Dezember Bestimmungen ein, die auf „grundlegende Modelle“ wie die großen Sprachmodelle (LLMs) abzielen, die KI-Chatbots wie z. B. antreiben ChatGPT. Kürzlich hat ein Ausschuss des Europäischen Parlaments diese aktualisierten Vorschriften genehmigt, die Sicherheitskontrollen und Risikomanagement durchsetzen.

Im Gegensatz zu den Vereinigten Staaten zeigt die EU eine größere Neigung, OpenAI zu hinterfragen. Der Europäischer Datenschutzausschuss hat die Einhaltung der Datenschutzgesetze durch ChatGPT aktiv überwacht. Es ist jedoch wichtig zu beachten, dass das KI-Gesetz immer noch möglichen Überarbeitungen unterliegt, was wahrscheinlich Altmans weltweite Reise erklärt, bei der er versucht, sich in der sich entwickelnden Landschaft der KI-Vorschriften zurechtzufinden.

Altman wiederholte bekannte Punkte aus seiner jüngsten Aussage vor dem Kongress und äußerte sowohl seine Besorgnis über die Risiken der KI als auch die Anerkennung ihrer potenziellen Vorteile. Er plädierte für eine Regulierung, einschließlich Sicherheitsanforderungen und einer Regierungsbehörde für Konformitätsprüfungen. Altman forderte einen Regulierungsansatz, der ein Gleichgewicht zwischen europäischen und amerikanischen Traditionen herstellt.

Altman warnte jedoch vor Vorschriften, die den Benutzerzugriff einschränken, kleineren Unternehmen schaden oder die Open-Source-KI-Bewegung behindern könnten. Die sich entwickelnde Haltung von OpenAI zur Offenheit, die sich auf den Wettbewerb bezieht, steht im Gegensatz zu seinen früheren Praktiken. Es ist erwähnenswert, dass alle neuen Vorschriften OpenAI grundsätzlich zugute kommen würden, indem sie einen Rahmen für die Rechenschaftspflicht bieten. Compliance-Prüfungen könnten auch die Kosten für die Entwicklung neuer KI-Modelle erhöhen und dem Unternehmen einen Vorteil in der wettbewerbsintensiven KI-Landschaft verschaffen.

Mehrere Länder haben ChatGPT verboten, darunter auch Italien. Nachdem OpenAI jedoch die Datenschutzkontrollen der Benutzer verbessert hatte, wurde das Verbot von der rechtsextremen italienischen Regierung aufgehoben. OpenAI muss möglicherweise weiterhin auf Bedenken eingehen und Zugeständnisse machen, um eine positive Beziehung zu Regierungen weltweit aufrechtzuerhalten, insbesondere angesichts seiner großen Nutzerbasis von über 100 Millionen aktiven ChatGPT-Nutzern.

Warum gehen Regierungen bei KI-Chatbots vorsichtig vor?

Es gibt eine Reihe von Gründen, warum Regierungen ChatGPT oder ähnliche KI-Modelle aus mehreren Gründen verbieten können:

- Fehlinformationen und Fake News: KI-Modelle wie ChatGPT können irreführende oder falsche Informationen generieren und so zur Verbreitung von Fehlinformationen beitragen. Regierungen können Verbote verhängen, um die Verbreitung unrichtiger oder schädlicher Inhalte zu verhindern.

- Unangemessener oder anstößiger Inhalt: KI-Modelle haben das Potenzial, Inhalte zu generieren, die unangemessen oder anstößig sind oder gegen kulturelle Normen und Werte verstoßen. Regierungen können ChatGPT verbieten, um Bürger davor zu schützen, auf anstößiges Material zu stoßen.

- Ethische Bedenken: KI-Modelle werfen ethische Fragen im Zusammenhang mit Datenschutz, Einwilligung und Voreingenommenheit auf. Regierungen können Verbote verhängen, um Bedenken hinsichtlich des Datenschutzes, des möglichen Missbrauchs personenbezogener Daten oder der Aufrechterhaltung von Vorurteilen bei KI-generierten Inhalten auszuräumen.

- Einhaltung gesetzlicher Vorschriften: KI-Modelle müssen sich an bestehende Gesetze und Vorschriften halten. Regierungen können Verbote verhängen, wenn sie feststellen, dass ChatGPT regulatorische Anforderungen wie Datenschutz oder Inhaltsstandards nicht erfüllt.

- Nationale Sicherheit und soziale Stabilität: Regierungen könnten KI-Modelle als potenzielle Bedrohung für die nationale Sicherheit oder die soziale Stabilität wahrnehmen. Sie können Verbote verhängen, um den Missbrauch von KI-Technologie für böswillige Zwecke zu verhindern oder um die Kontrolle über den Informationsfluss zu behalten.

Es ist erwähnenswert, dass die spezifischen Gründe für staatlich verhängte Verbote von ChatGPT je nach Gerichtsbarkeit unterschiedlich sein können und Entscheidungen durch eine Kombination dieser Faktoren beeinflusst werden rechtliche, ethische, gesellschaftliche und politische Faktoren. Informationen zu einigen aktuellen Risiken und unerwünschten Folgen von KI-Chatbots finden Sie in den folgenden aktuellen Artikeln:

- Aufgedeckte ChatGPT-Risiken: Verständnis der potenziellen Bedrohungen

- Die dunkle Seite von ChatGPT: Die menschlichen Kosten für den Erfolg der KI

Source: Sam Altman von OpenAI droht mit EU-Austritt inmitten von Gesprächen über KI-Regulierung